Sıradan en küçük kareler - Ordinary least squares

| Bir serinin parçası |

| Regresyon analizi |

|---|

| Modeller |

| Tahmin |

| Arka plan |

Olarak istatistik , sıradan en küçük kareler ( en küçük kareler ), bir tür azından doğrusal kareler bilinmeyen tahmin edilmesi için bir yöntem parametrelerinin bir de doğrusal regresyon modeli. OLS , bir dizi açıklayıcı değişkenin doğrusal bir fonksiyonunun parametrelerini en küçük kareler ilkesiyle seçer : verilen veri kümesinde gözlenen bağımlı değişken ( gözlenen değişkenin değerleri) ile tahmin edilenler arasındaki farkların karelerinin toplamını en aza indirgemek bağımsız değişkenin lineer fonksiyonu ile .

Geometrik olarak, bu, kümedeki her veri noktası ile regresyon yüzeyindeki karşılık gelen nokta arasındaki bağımlı değişkenin eksenine paralel olan uzaklıkların karesinin toplamı olarak görülür; farklar ne kadar küçükse, model verilere o kadar iyi uyar. . Ortaya çıkan tahmin edici , özellikle regresyon denkleminin sağ tarafında tek bir regresörün olduğu basit bir lineer regresyon durumunda basit bir formülle ifade edilebilir .

Olduğu tahmincisi EKK tutarlı önsavının olduğunda eksojen ve-by Gauss-Markov teoremi - lineer yansız tahmin edicilerin sınıfında optimum zaman hatalar vardır homoskedastik ve otokorelasyonsuz . Bu koşullar altında, OLS yöntemi , hatalar sonlu varyanslara sahip olduğunda minimum varyanslı ortalama yansız tahmin sağlar . Hataların normal dağıldığına dair ek varsayım altında , OLS maksimum olabilirlik tahmincisidir .

Doğrusal model

Verilerin gözlemlerden oluştuğunu varsayalım . Her gözlem skalar yanıtı içeren ve bir sütun vektörü içinde , yani parametreleri (önsavının), . Bir de doğrusal regresyon modeli , yanıt değişkeni, Regresörlerin doğrusal bir fonksiyonudur:

veya vektör biçiminde,

burada , daha önce tanıtıldığı gibi , tüm açıklayıcı değişkenlerin -th gözleminin bir sütun vektörüdür ; bilinmeyen parametrelerin bir vektörüdür; ve skaler , -th gözleminin gözlemlenmemiş rastgele değişkenlerini ( hataları ) temsil eder . açıklayıcılar dışındaki kaynaklardan gelen yanıtlar üzerindeki etkileri açıklar . Bu model ayrıca matris notasyonunda şu şekilde yazılabilir:

burada ve vardır tepki değişkenleri vektörler ve hatalar gözlemler ve bir bir de de denir Regresör matrisi, tasarım matris Satır, olduğu ve ihtiva tüm açıklayıcı değişkenler inci gözlemler.

Kural olarak, sabit terim her zaman regresörler kümesine dahil edilir , örneğin all için alınır . Bu regresöre karşılık gelen katsayıya kesme denir .

Regresörlerin bağımsız olması gerekmez: Regresörler arasında arzu edilen herhangi bir ilişki olabilir (doğrusal bir ilişki olmadığı sürece). Örneğin, yanıtın hem bir değere hem de karesine doğrusal olarak bağlı olduğundan şüphelenebiliriz; bu durumda değeri başka bir regresörün karesi olan bir regresörü dahil edeceğiz. Bu durumda, model olacağını kuadratik ikinci regresör içinde, ama hiçbiri-az hala kabul edilir doğrusal modeli, çünkü modeli olan (parametrelerde hala çizgisel ).

Matris/vektör formülasyonu

Aşırı belirlenmiş bir sistem düşünün

arasında lineer denklem içinde bilinmeyen katsayılar , ile . (Not: yukarıdaki gibi bir lineer model için, içindeki tüm öğeler veri noktaları hakkında bilgi içermez. İlk sütun bir ile doldurulur, . Sadece diğer sütunlar gerçek verileri içerir. Yani burada regresör sayısı artı bire eşittir. ) Bu matris formunda şu şekilde yazılabilir:

nerede

Böyle bir sistemin genellikle kesin bir çözümü yoktur, bu nedenle amaç, ikinci dereceden minimizasyon problemini çözme anlamında "en iyi" denklemlere uyan katsayıları bulmaktır.

amaç fonksiyonunun verildiği yerde

Bu kriteri seçme gerekçesi aşağıdaki Özellikler'de verilmiştir. Bu minimize etme sorunu da koşuluyla, tek bir çözümü vardır matrisin sütunları olan lineer bağımsız çözerek verilen normal bir denklem

Matris olarak bilinen Gram matris ve matris olarak bilinen an matris Regresörlerin regressand arasında. Son olarak, en küçük kareler hiperdüzleminin katsayı vektörü şu şekilde ifade edilir:

veya

Tahmin

b'nin β parametre vektörü için bir "aday" değer olduğunu varsayalım . Miktarı y ı - X i , T B adı verilen kalıntı için i veri noktası arasındaki önlemler düşey mesafe, inci gözlem ( x i , y i ) ve hiper y = x T B , ve böylece derecesini ölçmek gerçek veriler ve model arasında uyum sağlar. Kare toplamlarının ( SSR ) (ayrıca kareler hata toplamı ( ESS ) ya da rezidüel kareler toplamı ( RSS )) bu model, uyum bir ölçüsüdür:

burada T matris devriğini gösterir ve X satırları , bağımlı değişkenin belirli bir değeriyle ilişkili tüm bağımsız değişkenlerin değerlerini belirtir, X i = x i T'dir . Bu toplamı minimize eden b değerine β için OLS tahmincisi denir . S ( b ) işlevi , b'de pozitif tanımlı Hessian ile ikinci derecedendir ve bu nedenle bu işlev , açık formülle verilebilecek benzersiz bir global minimuma sahiptir : [kanıt]

Ürün K = X , T x a, gram matris ve tersi, Q, = N -1 , bir kofaktör matrisi arasında p yakından ilişkili, kovaryans matrisinin , Cı- P . ( X T X ) –1 X T = Q X T matrisi, X'in Moore-Penrose sözde -ters matrisi olarak adlandırılır. Bu formülasyon, tahminin ancak ve ancak, aralarında mükemmel bir çoklu doğrusal bağlantı olmaması durumunda gerçekleştirilebileceğini vurgular . açıklayıcı değişkenler (ki bu, gram matrisinin tersi olmamasına neden olur).

Olduğunu tahmin sonra β , edilen değeri (ya da öngörülen değerler regresyonundan) olacaktır

burada P = X ( X T X ) −1 X T , X'in sütunları tarafından yayılan V uzayına izdüşüm matrisidir . Bu matris P aynı zamanda bazen şapka matrisi olarak da adlandırılır çünkü y değişkenine "bir şapka koyar" . P ile yakından ilişkili başka bir matris, yok edici matristir M = I n − P ; bu, V'ye dik uzay üzerine bir izdüşüm matrisidir . Hem matris P ve M olan simetrik ve İdempotent (yani P 2 = P ve M 2 = E ve veri matrisi ile ilgilidir) X kimlikleri ile PX = X ve MX = 0 . Matrix M , regresyondan kalanları oluşturur :

Bu artıkları kullanarak, indirgenmiş ki-kare istatistiğini kullanarak σ 2 değerini tahmin edebiliriz :

Payda, n - p , istatistiksel serbestlik derecesidir . İlk nicelik, s 2 , σ 2 için OLS tahmini iken, ikincisi, , σ 2 için MLE tahminidir . Büyük örneklerde iki tahmin edici oldukça benzerdir; İlk tahmincisi daima edilir tarafsız ikinci tahmincisi önyargılı iken, ancak daha küçük sahiptir ortalama karesel hata . Uygulamada s 2 , hipotez testi için daha uygun olduğu için daha sık kullanılır. Karekökü s 2 olarak adlandırılır regresyon standart hata , regresyon standart hata , veya denklemin standart hata .

OLS regresyonunun uyum iyiliğini, X'e gerileyerek örnekteki ilk varyasyonun ne kadar azaltılabileceğini karşılaştırarak değerlendirmek yaygındır . Belirleme katsayısı R 2 bağımlı değişken bir "toplam" varyansa varyans "açıklandığı" bir oranı olarak tanımlanır y kareler regresyon toplamı artıkların karelerinin toplamı eşittir durumlarda:

burada TSS, bağımlı değişken için karelerin toplam toplamıdır ve bir n × n matrisidir. ( bir sabit üzerindeki regresyona eşdeğer bir merkezleme matrisidir ; sadece bir değişkenden ortalamayı çıkarır.) R 2'nin anlamlı olması için, regresörler üzerindeki verilerin X matrisi, aşağıdakileri temsil edecek bir sütun vektörü içermelidir. katsayısı regresyon kesişimi olan sabit. Bu durumda, R ' 2 , her zaman değerleri uyum iyi derecede gösteren 1'e yakın olan, 0 ile 1 arasında bir sayı olacaktır.

Bağımsız değişkenin bağımlı değişkenin bir fonksiyonu olarak tahminindeki varyans, Polinom en küçük kareler makalesinde verilmiştir .

Basit doğrusal regresyon modeli

X veri matrisi yalnızca iki değişken, bir sabit ve bir skaler regresör x i içeriyorsa , buna "basit regresyon modeli" denir. Bu durum, manuel hesaplama için bile uygun olan çok daha basit formüller sağladığından, genellikle başlangıç istatistik sınıflarında dikkate alınır. Parametreler genel olarak ( α , β ) olarak belirtilir :

Bu durumda en küçük kareler tahminleri basit formüllerle verilir.

alternatif türevler

Bir önceki bölümde en küçük kareler tahmincisi , modelin artık karelerinin toplamını minimize eden bir değer olarak elde edilmiştir. Ancak aynı tahmin ediciyi diğer yaklaşımlardan da elde etmek mümkündür. Her durumda OLS tahmincisi formülü aynı kalır: ^ β = ( X T X ) −1 X T y ; tek fark, bu sonucu nasıl yorumladığımızdır.

Projeksiyon

Matematikçiler için, OLS, β'nın bilinmeyen olduğu Xβ ≈ y aşırı belirlenmiş bir lineer denklem sistemine yaklaşık bir çözümdür . Sistemini varsayarsak (denklem sayısı tam olarak çözülemez n bilinmeyenler sayısının çok daha büyüktür p ), biz sağ ve sol yön tarafı arasında en küçük tutarsızlığı sağlayabilir çözüm aramaktadır. Başka bir deyişle, tatmin edici bir çözüm arıyoruz.

nerede ||·|| standart L 2 normu içinde n- boyutlu Öklid alan R , n . Tahmin edilen Xβ miktarı , sadece regresör vektörlerinin belirli bir lineer birleşimidir. Bu nedenle, artık vektör y - Xβ küçük uzunluğa sahip olacaktır y olan dikey olarak yansıtılan üzerine lineer alt uzay yayılmış ve sütunlara göre X . OLS tahmin bu durumda katsayıları olarak yorumlanabilir vektör ayrışma içinde ^ y = Py temelinde boyunca X .

Başka bir deyişle, minimumdaki gradyan denklemleri şu şekilde yazılabilir:

Bu denklemler bir geometrik yorumu artıkların vektörü, yani ortogonal olan kolon alanı arasında X nokta ürün için, sıfıra eşit olduğu bir konformal vektörü, v . Bu , mümkün olan tüm vektörlerin en kısasının olduğu anlamına gelir , yani artıkların varyansı mümkün olan en düşük değerdir. Bu sağda gösterilmiştir.

Bir matrisin tekil olmadığı ve K T X = 0 (cf. Ortogonal projeksiyonlar ) varsayımıyla bir K matrisi tanıtıldığında , artık vektör aşağıdaki denklemi sağlamalıdır:

Doğrusal en küçük karelerin denklemi ve çözümü aşağıdaki gibi tanımlanır:

Buna bakmanın başka bir yolu, regresyon çizgisini, veri kümesindeki herhangi iki noktanın birleşiminden geçen çizgilerin ağırlıklı ortalaması olarak düşünmektir. Bu hesaplama yöntemi, hesaplama açısından daha pahalı olmasına rağmen, OLS üzerinde daha iyi bir sezgi sağlar.

Maksimum olasılık

OLS tahmincisi, hata terimleri için normallik varsayımı altında maksimum olabilirlik tahmincisi (MLE) ile aynıdır . [kanıt] Bu normallik varsayımı tarihsel öneme sahiptir, çünkü Yule ve Pearson tarafından lineer regresyon analizindeki erken çalışma için temel sağlar . MLE'nin özelliklerinden , normallik varsayımı karşılanırsa , OLS tahmincisinin asimptotik olarak verimli olduğunu ( varyans için Cramér-Rao sınırına ulaşma anlamında) çıkarabiliriz .

Genelleştirilmiş moment yöntemi

Gelen iid durumda en küçük kareler tahmincisi olarak ta görülebilir GMM zaman şartlarının kaynaklanan tahmin

Bu moment koşulları, regresörlerin hatalarla ilişkisiz olması gerektiğini belirtir. Yana x i a, p -vector, zaman şartlarının sayısı parametre vektörü boyutuna eşit olan p ve böylece sistem tam olarak tanımlanır. Bu, tahmin edicinin ağırlıklandırma matrisinin seçimine bağlı olmadığı klasik GMM durumudur.

Orijinal katı dışsallık varsayımının E[ ε i | x i ] = 0 , yukarıda belirtilenden çok daha zengin bir moment koşulları kümesi anlamına gelir. Özellikle, bu varsayım, herhangi bir vektör fonksiyonu ƒ için , E[ ƒ ( x i )· ε i ] = 0 moment koşulunun geçerli olacağını ima eder . Bununla birlikte, ƒ fonksiyonunun optimal seçiminin ƒ ( x ) = x almak olduğu Gauss-Markov teoremi kullanılarak gösterilebilir , bu da yukarıda verilen moment denklemiyle sonuçlanır.

Özellikler

varsayımlar

OLS tekniğini uygulanabilir kılmak için doğrusal regresyon modelinin oluşturulabileceği birkaç farklı çerçeve vardır . Bu ayarların her biri aynı formülleri ve aynı sonuçları üretir. Tek fark, yöntemin anlamlı sonuçlar vermesi için uygulanması gereken yorum ve varsayımlardır. Uygulanabilir çerçevenin seçimi, çoğunlukla eldeki verilerin doğasına ve gerçekleştirilmesi gereken çıkarım görevine bağlıdır.

Yorumdaki farklılık çizgilerinden biri, regresörlerin rastgele değişkenler olarak mı yoksa önceden tanımlanmış sabitler olarak mı ele alınacağıdır. İlk durumda ( rasgele tasarım ) önsavının x i , rastgele ve birlikte örneklenmiş olan y ı 'bazı s nüfus bir olduğu gibi, gözlem çalışma . Bu yaklaşım , tahmin edicilerin asimptotik özelliklerinin daha doğal çalışmasına izin verir . Diğer yorumlamada ( sabit tasarım ), X regresörleri bir tasarım tarafından belirlenen bilinen sabitler olarak ele alınır ve y , bir deneyde olduğu gibi X değerlerine göre koşullu olarak örneklenir . Pratik amaçlar için, bu ayrım genellikle önemsizdir, çünkü tahmin ve çıkarım, X üzerinde koşullandırma sırasında yürütülür . Bu makalede belirtilen tüm sonuçlar rastgele tasarım çerçevesi içindedir.

Klasik doğrusal regresyon modeli

Klasik model, "sonlu örnek" tahmini ve çıkarımına odaklanır, yani gözlem sayısı n sabittir. Bu, OLS'nin asimptotik davranışını inceleyen ve gözlem sayısının sonsuza kadar büyümesine izin verilen diğer yaklaşımlarla çelişir .

- Doğru şartname . Doğrusal işlevsel biçim, gerçek veri oluşturma sürecinin biçimiyle örtüşmelidir.

-

Katı dışsallık . Regresyondaki hatalar koşullu ortalama sıfıra sahip olmalıdır :

- Dışsallık varsayımının hemen sonucu, hataların ortalama sıfıra sahip olması: E[ ε ] = 0 ve regresörlerin hatalarla ilişkisiz olmasıdır: E[ X T ε ] = 0 .

- OLS teorisi için dışsallık varsayımı kritik öneme sahiptir. Tutarsa, regresör değişkenlere eksojen denir . Olmazsa, hata terimiyle ilişkili olan regresörlere endojen denir ve OLS tahminleri geçersiz olur. Böyle bir durumda, çıkarımı gerçekleştirmek için araç değişkenler yöntemi kullanılabilir.

-

Doğrusal bağımlılık yok . X'teki regresörlerin tümü lineer olarak bağımsız olmalıdır . Matematiksel olarak bu, X matrisinin neredeyse kesin olarak tam sütun sıralamasına sahip olması gerektiği anlamına gelir :

- Genellikle, regresörlerin en azından ikinci momente kadar sonlu momentleri olduğu da varsayılır. O halde Q xx = E[ X T X / n ] matrisi sonlu ve pozitif yarı tanımlıdır.

- Bu varsayım ihlal edildiğinde, regresörlere doğrusal bağımlı veya mükemmel çoklu doğrusal bağlantı denir . Bu durumda , aynı lineer bağımlı alt uzayda bulunan regresörlerin yeni değerleri için y değerlerinin tahmini hala mümkün olsa da , regresyon katsayısının β değeri öğrenilemez .

-

Küresel hatalar :

- burada I , n olan birim matris boyutta , n ve σ 2 , her gözlem varyansını belirleyen bir parametredir. Bu σ 2 , genellikle tahmin edilmesine rağmen, modelde rahatsız edici bir parametre olarak kabul edilir . Bu varsayım ihlal edilirse, OLS tahminleri hala geçerlidir, ancak artık verimli değildir.

- Bu varsayımı iki bölüme ayırmak gelenekseldir:

- Homoscedasticity : E[ ε i 2 | X ] = σ 2 , bu, hata terimininher gözlemdeaynı varyansa σ 2 sahip olduğu anlamına gelir. Bu gereklilik ihlal edildiğinde buna değişen varyans denir, böyle bir durumda daha verimli bir tahmin edici ağırlıklı en küçük kareler olacaktır . Hatalar sonsuz varyansa sahipse, OLS tahminleri de sonsuz varyansa sahip olacaktır (her ne kadar büyük sayılar yasasına göre hatalar sıfır ortalamaya sahip olduğu sürece yine de gerçek değerlere yöneleceklerdir). Bu durumda, sağlam tahmin teknikleri önerilir.

- Otokorelasyon yok : hatalar gözlemler arasında korelasyonsuzdur : E[ ε i ε j | i ≠ j için X ] = 0 . Bu varsayım, zaman serisi verileri, panel verileri , küme örnekleri, hiyerarşik veriler, tekrarlanan ölçüm verileri, boylamsal veriler ve bağımlı diğer veriler bağlamında ihlal edilebilir . Bu gibi durumlarda genelleştirilmiş en küçük kareler , OLS'den daha iyi bir alternatif sağlar. Otokorelasyon için başka bir ifade seri korelasyondur .

-

Normallik . Bazen ek olarak, hataların regresörlere bağlı olarak normal dağılıma sahip olduğu varsayılır :

- Bu varsayım, OLS yönteminin geçerliliği için gerekli değildir, ancak gerekli olduğu durumda (özellikle hipotez testleri alanında) bazı ek sonlu örnek özellikleri oluşturulabilir. Ayrıca hatalar normal olduğunda, OLS tahmincisi maksimum olabilirlik tahmincisine (MLE) eşdeğerdir ve bu nedenle tüm düzenli tahmin ediciler sınıfında asimptotik olarak etkindir . Daha da önemlisi, normallik varsayımı yalnızca hata terimleri için geçerlidir; Popüler bir yanılgının aksine, yanıt (bağımlı) değişkeninin normal dağılması gerekli değildir.

Bağımsız ve aynı şekilde dağıtılmış (iid)

Bazı uygulamalarda, özellikle enine kesit verileriyle , ek bir varsayım uygulanır - tüm gözlemler bağımsız ve aynı şekilde dağıtılır. Bu, tüm gözlemlerin, daha önce listelenen tüm varsayımları daha basit ve yorumlanmasını kolaylaştıran rastgele bir örnekten alındığı anlamına gelir . Ayrıca bu çerçeve , veri üretme sürecinden yeni bağımsız gözlemler getirmenin teorik bir olasılığı olarak anlaşılan asimptotik sonuçların (örnek boyutu n → ∞ olarak ) belirtilmesine izin verir . Bu durumda varsayımların listesi:

- iid gözlemler : ( x ben , y ben ) tüm i ≠ j için ( x j , y j ) ' den bağımsızdır ve aynı dağılıma sahiptir ;

- Hiçbir mükemmel çoklu doğrusal : Q, xx = E [ x i x i T ] a, pozitif tanımlı bir matris ;

- dışsallık : E[ ε i | x ben ] = 0;

- homoscedasticity : Var[ ε i | x ben ] = σ 2 .

Zaman serisi modeli

- Stokastik işlem { x i , y i } olan sabit ve ergodik ; { x i , y ben } durağan değilse, { x i , y ben } birlikte bütünleşmediği sürece OLS sonuçları genellikle sahtedir .

- Regresörler önceden belirlenir : tüm i = 1, ..., n için E[ x ben ε ben ] = 0 ;

- P x s matrisi S xx = E [ x i x i T ] tam sıralı olan ve bu nedenle pozitif tanımlı ;

- { x i ε ben } ikinci momentlerin sonlu matrisi olan bir martingale fark dizisidir Q xxε ² = E[ ε ben 2 x ben x ben T ] .

Sonlu örnek özellikleri

Altında Öncelikle sıkı eksojenite varsayımı EKK tahmin edicileri ve s 2 olan tarafsız beklenen değerler parametrelerin gerçek değerleri ile çakışacak yani: [geçirmez]

Katı dışsallık geçerli değilse (birçok zaman serisi modelinde olduğu gibi, dışsallığın yalnızca geçmiş şoklara göre varsayıldığı ancak gelecekteki şoklara göre değil), bu tahminciler sonlu örneklerde yanlı olacaktır.

Varyans-kovaryans matrisi (veya basitçe kovaryans matrisi ) arasında eşittir

Özellikle, her katsayının standart hatası , bu matrisin j -inci köşegen elemanının kareköküne eşittir . Bu standart hatanın tahmini, bilinmeyen σ 2 miktarının tahmini s 2 ile değiştirilmesiyle elde edilir . Böylece,

Tahmin edicinin modelden kalanlarla ilişkisiz olduğu da kolayca gösterilebilir :

Gauss-Markov teoremi altında olduğunu belirtmektedir küresel hatalar varsayımı (olduğunu, hatalar olmalı ilintisiz ve homoskedastik tahmincisi) lineer yansız tahmin edicilerin sınıfında etkilidir. Buna en iyi doğrusal yansız tahmin edici (MAVİ) denir . Bunu başka tahmincisi bulmak için sanki Verimlilik anlaşılmalıdır lineer olacağını y ve tarafsız ardından,

Bu, negatif-tanımlı olmayan bir matris olması anlamında . Bu teorem, optimalliği yalnızca oldukça kısıtlayıcı olan doğrusal yansız tahmin ediciler sınıfında kurar. Hata terimlerinin dağılımına bağlı olarak ε , diğer doğrusal olmayan tahmin ediciler OLS'den daha iyi sonuçlar verebilir.

normallik varsayarsak

Şimdiye kadar listelenen özelliklerin tümü, hata terimlerinin altında yatan dağılımdan bağımsız olarak geçerlidir. Ancak, normallik varsayımının geçerli olduğunu varsaymaya istekliyseniz (yani, ε ~ N (0, σ 2 I n ) ), o zaman OLS tahmincilerinin ek özellikleri belirtilebilir.

Tahmin edici , daha önce verildiği gibi ortalama ve varyansla normal olarak dağıtılır:

burada Q , kofaktör matrisidir . Bu tahmin edici , model için Cramér-Rao sınırına ulaşır ve bu nedenle tüm yansız tahmin ediciler sınıfında optimaldir. Gauss-Markov teoreminin aksine , bu sonucun hem lineer hem de lineer olmayan tahmin ediciler arasında optimalliği oluşturduğuna, ancak sadece normal dağılmış hata terimleri durumunda olduğuna dikkat edin.

Tahmin edici s 2 , ki-kare dağılımıyla orantılı olacaktır :

Bu tahmin varyansı eşittir 2 σ 4 / ( n - p ) , elde etmeyen Cramer-Rao bağlanmış bir 2 σ 4 / n . Ancak , varyansı s 2 kestiricisinden daha küçük olan σ 2'nin yansız kestiricilerinin olmadığı gösterilmiştir . Önyargılı tahmincilere izin vermeye istekliysek ve modelin karesel artıklarının (SSR) toplamı ile orantılı tahmin edici sınıfını göz önünde bulundurursak, bu sınıftaki en iyi ( ortalama kare hatası anlamında ) tahmin edici olacaktır. ~ σ 2 = SSR / ( n − p + 2) , bu, yalnızca bir regresör ( p = 1 ) olduğunda Cramér–Rao sınırını bile geçer .

Ayrıca, tahmin ve s 2 olan , bağımsız , regresyon için T ve F-test yapımında yararlıdır gelir aslında.

Etkili gözlemler

Daha önce olduğu gibi sözü edilen tahmin edici lineerdir y bağımlı değişkenlerin lineer kombinasyonu temsil eder, yani, y i . Bu lineer kombinasyondaki ağırlıklar, X regresörlerinin fonksiyonlarıdır ve genellikle eşit değildir. Yüksek ağırlıklı gözlemler , tahmin edicinin değeri üzerinde daha belirgin bir etkiye sahip oldukları için etkili olarak adlandırılır .

Biz belirli kaldırmak etkili olan gözlemler analiz etmek j -inci gözlem ve tahmini miktarlar (benzer Değişikliğin olacak ne kadar dikkate sustalı çakı yöntemiyle ). β için OLS tahmin edicisindeki değişimin şuna eşit olacağı gösterilebilir.

burada h j = x j T ( X T X ) −1 x j , şapka matrisinin P'nin j -inci köşegen elemanıdır ve x j , j -inci gözleme karşılık gelen regresörlerin vektörüdür . Benzer bir şekilde, tahmin edilen değer değişiklik j veri kümesinden bu gözlemi atlama kaynaklanan-inci gözlem eşit olacaktır

Şapka matrisinin özelliklerinden, 0 ≤ h j ≤ 1 ve toplamları p'ye eşittir , böylece ortalama olarak h j ≈ p/n . Bu miktarlar h j denir kaldıraç ve yüksek olan gözlemler h j denir kaldıraç noktalarını . Genellikle, yüksek kaldıraçlı gözlemler, hatalı olmaları, aykırı olmaları veya başka bir şekilde veri kümesinin geri kalanının atipik olması durumunda daha dikkatli bir şekilde incelenmelidir.

bölümlenmiş regresyon

Bazen regresyondaki değişkenler ve karşılık gelen parametreler mantıksal olarak iki gruba ayrılabilir, böylece regresyon şekillenir.

burada X, 1 ve X, 2 boyutlara sahip , n x s 1 , n x P 2 ve β 1 , β 2 olan p 1 x 1 ve p 2 ile x 1 vektörler, s 1 + p 2 = s .

Frisch-Waugh-Lovell teoremi bu regresyon artıklar belirtmektedir ve en küçük kareler tahmin artıklar sayısal aynı olacaktır ve en küçük kareler için tahmin p 2 , aşağıdaki regresyon:

burada M 1 olduğu Yokedici matris regresyonu x 1 .

Teorem, bir dizi teorik sonuç oluşturmak için kullanılabilir. Örneğin, bir sabit ve başka bir regresör ile bir regresyona sahip olmak, bağımlı değişkenden ve regresörden ortalamaları çıkarmaya ve ardından regresyonu, sabit terim olmadan, anlamı azaltılmış değişkenler için çalıştırmaya eşdeğerdir.

kısıtlı tahmin

Regresyondaki katsayıların bir lineer denklem sistemini sağladığının bilindiğini varsayalım.

burada Q , tam sıralı bir p × q matrisidir ve c , bilinen sabitlerin bir q × 1 vektörüdür, burada q < p . Bu durumda, en küçük kareler tahmini, A kısıtına tabi olan modelin artık karelerinin toplamının minimizasyonuna eşdeğerdir . Kısıtlı en küçük kareler (CLS) tahmin açık bir formül verilebilir:

Kısıtlı tahmin edici için bu ifade, X T X matrisi ters çevrilebilir olduğu sürece geçerlidir . Bu makalenin başından itibaren bu matrisin tam ranklı olduğu varsayıldı ve rank koşulu başarısız olduğunda β'nın tanımlanamayacağı belirtildi. Bununla birlikte, A kısıtlamasının eklenmesi β'yı tanımlanabilir hale getirebilir , bu durumda tahmin edicinin formülünü bulmak istenir. Tahminci şuna eşittir:

burada R bir p ×( p − q ) matrisidir, öyle ki [ QR ] matrisi tekil değildir ve R T Q = 0 . Böyle bir matris her zaman bulunabilir, ancak genellikle benzersiz değildir. X T X'in ters çevrilebilir olması durumunda ikinci formül birinciyle çakışır .

Büyük numune özellikleri

En küçük kareler tahmin edicileri , doğrusal regresyon modeli parametrelerinin β nokta tahminleridir . Bununla birlikte, genellikle bu tahminlerin, parametrelerin gerçek değerlerine ne kadar yakın olabileceğini de bilmek isteriz. Başka bir deyişle, aralık tahminlerini oluşturmak istiyoruz .

Biz hata teriminin dağılımı hakkında herhangi tahmininde bulunmayan yana ε i , tahmin edicilerin dağılımını anlaması mümkün değildir ve . Yine de, örneklem büyüklüğü n sonsuza giderken asimptotik özelliklerini türetmek için merkezi limit teoremini uygulayabiliriz . Örnek boyutu zorunlu olarak sonlu olsa da , OLS tahmincisinin gerçek dağılımının asimptotik sınırına yakın olması için n'nin "yeterince büyük" olduğunu varsaymak gelenekseldir .

Bu model, varsayımlar altında, en az kareli tahmincisi olduğunu gösterebilir p olan tutarlı (olduğunu olasılık yakınsamaktadır için P : ve asimptotik normal) [geçirmez]

nerede

Aralıklar

Bu asimptotik dağılımı kullanarak , vektörün j -inci bileşeni için yaklaşık iki taraflı güven aralıkları şu şekilde oluşturulabilir:

- de 1 - α güven seviyesinde,

burada q belirtmektedir miktarsal fonksiyonunu , standart normal dağılımın ve [·] jj olan j matris inci çapraz eleman.

Benzer şekilde, σ 2 için en küçük kareler tahmincisi de tutarlı ve asimptotik olarak normaldir ( e i'nin dördüncü momentinin mevcut olması şartıyla ) sınırlayıcı dağılımla

Bu asimptotik dağılımlar tahmin, hipotezlerin test edilmesi, diğer tahmin edicilerin oluşturulması vb. için kullanılabilir. Örnek olarak tahmin problemini ele alalım. Regresörlerin dağılım alanı içinde bir nokta olduğunu varsayalım ve kişi bu noktada yanıt değişkeninin ne olacağını bilmek istiyor. Ortalama tepki miktar ise, tahmin edilen cevap olup . Açıkça tahmin edilen yanıt rastgele bir değişkendir, dağılımı aşağıdakilerden türetilebilir :

bu, oluşturulacak ortalama yanıt için yapı güven aralıklarına izin verir :

- de 1 - α güven seviyesinde.

Hipotez testi

İki hipotez testi özellikle yaygın olarak kullanılmaktadır. Birincisi, tahmin edilen regresyon denkleminin, yanıt değişkeninin tüm değerlerinin örnek ortalamasına eşit olduğunu basitçe tahmin etmekten daha iyi olup olmadığını bilmek ister (eğer değilse, açıklayıcı gücünün olmadığı söylenir). Boş hipotez tahmini regresyon açıklayıcı bir değeri olan bir kullanılarak test edilir , F-testi . Hesaplanan F değeri, önceden seçilen anlamlılık düzeyi için kritik değerini aşacak kadar büyük bulunursa, sıfır hipotezi reddedilir ve regresyonun açıklayıcı güce sahip olduğu alternatif hipotezi kabul edilir. Aksi takdirde, açıklayıcı gücün olmadığı sıfır hipotezi kabul edilir.

İkinci olarak, ilgilenilen her açıklayıcı değişken için, tahmin edilen katsayısının sıfırdan önemli ölçüde farklı olup olmadığını, yani bu özel açıklayıcı değişkenin aslında yanıt değişkenini tahmin etmede açıklayıcı güce sahip olup olmadığını bilmek istenir. Burada boş hipotez, gerçek katsayının sıfır olmasıdır. Bu hipotez, katsayı tahmininin standart hatasına oranı olarak katsayının t-istatistiği hesaplanarak test edilir . t istatistiği önceden belirlenmiş bir değerden büyükse, sıfır hipotezi reddedilir ve değişkenin katsayısı sıfırdan önemli ölçüde farklı olan açıklayıcı güce sahip olduğu bulunur. Aksi takdirde, gerçek katsayının sıfır değerinin sıfır hipotezi kabul edilir.

Ek olarak, Chow testi , iki alt örneğin her ikisinin de aynı temel gerçek katsayı değerlerine sahip olup olmadığını test etmek için kullanılır. Her bir alt kümedeki ve birleştirilmiş veri kümesindeki regresyonların artık karelerinin toplamı, bir F-istatistiğinin hesaplanmasıyla karşılaştırılır; eğer bu kritik bir değeri aşarsa, iki altküme arasında fark olmadığına dair boş hipotez reddedilir; aksi halde kabul edilir.

Gerçek verilerle örnek

Aşağıdaki veri seti, 30-39 yaş arası Amerikalı kadınların ortalama boy ve kilolarını vermektedir (kaynak: The World Almanac and Book of Facts, 1975 ).

Yükseklik (m) 1.47 1.50 1.52 1.55 1.57 1.60 1,63 1.65 1.68 1.70 1.73 1.75 1.78 1.80 1.83 Ağırlık (kg) 52.21 53.12 54.48 55.84 57.20 58.57 59.93 61.29 63.11 64.47 66.28 68.10 69.92 72.19 74.46

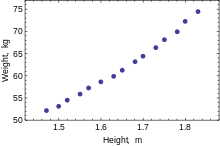

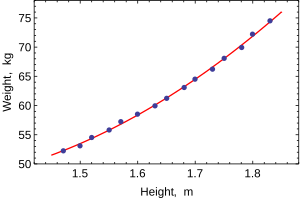

Yalnızca bir bağımlı değişken modellendiğinde, bir dağılım grafiği bağımlı değişken ile regresörler arasındaki ilişkinin biçimini ve gücünü önerecektir. Ayrıca, uygun bir regresyon modelinin yorumlanmasını karmaşıklaştırabilecek verilerin aykırı değerleri, değişen varyanslılığı ve diğer yönlerini ortaya çıkarabilir. Dağılım grafiği, ilişkinin güçlü olduğunu ve ikinci dereceden bir fonksiyon olarak tahmin edilebileceğini gösterir. OLS, HEIGHT 2 regresörünü tanıtarak doğrusal olmayan ilişkileri işleyebilir . Regresyon modeli daha sonra çoklu doğrusal bir model haline gelir:

En popüler istatistik paketlerinin çıktısı şuna benzer:

Yöntem En küçük kareler Bağımlı değişken AĞIRLIK gözlemler 15

Parametre Değer Std. Hata t-istatistik p değeri

128.8128 16.3083 7.8986 0.0000 –143.1620 19.8332 –7.2183 0.0000 61.9603 6.0084 10.3122 0.0000

R, 2 0.9989 gerileme SE 0.2516 Ayarlanmış R 2 0.9987 Model toplamı metrekare 692.61 Log olasılığı 1.0890 Kalan toplam metrekare 0.7595 Durbin-Watson durumu. 2.1013 Toplam metrekare 693,37 Akaike kriteri 0.2548 F-istatistiği 5471.2 Schwarz kriteri 0.3964 p-değeri (F-stat) 0.0000

Bu tabloda:

- Değer sütun parametrelerin en küçük kareler tahminleri verir β j

- Std hata sütunda, standart hatalar her katsayı tahmin:

- T-istatistiği ve p-değeri sütunları katsayılarının bir sıfıra eşit olabilir olup olmadığını test edilir. T , sadece şu şekilde hesaplanır -statistic . Hatalar ε normal bir dağılımı takip ediyorsa, t bir Student-t dağılımını takip eder. Daha zayıf koşullar altında, t asimptotik olarak normaldir. Büyük t değerleri , boş hipotezin reddedilebileceğini ve karşılık gelen katsayının sıfır olmadığını gösterir. İkinci sütun, p- değeri , hipotez testinin sonuçlarını anlamlılık düzeyi olarak ifade eder . Geleneksel olarak, 0,05'ten küçük p -değerleri, popülasyon katsayısının sıfır olmadığına dair kanıt olarak alınır.

- R-kare , regresyonun uyum iyiliğini gösteren belirleme katsayısıdır . Bu istatistik, eğer uyum mükemmelse bire, X regresörlerinin herhangi bir açıklayıcı gücü olmadığında ise sıfıra eşit olacaktır . Bu, R-kare popülasyonunun taraflı bir tahminidir ve alakasız olsalar bile ilave regresörler eklenirse asla azalmayacaktır.

- Düzeltilmiş R-kare , regresyonun açıklayıcı gücüne katkıda bulunmayan fazla sayıda regresör için ceza vermek üzere tasarlanmış, biraz değiştirilmiş bir versiyonudur . Bu istatistik her zaman 'den küçüktür , yeni regresörler eklendikçe azalabilir ve hatta uygun olmayan modeller için negatif olabilir:

- Log-olasılığı , hataların normal dağılımı takip ettiği varsayımı altında hesaplanır. Varsayım çok makul olmasa da, bu istatistik yine de LR testlerinin yürütülmesinde kullanımını bulabilir.

- Durbin-Watson istatistiği , artıklar arasında herhangi bir seri korelasyon kanıtı olup olmadığını test eder. Genel bir kural olarak, 2'den küçük değer, pozitif korelasyonun bir kanıtı olacaktır.

- Akaike bilgi kriteri ve Schwarz kriter hem modeli seçimi için kullanılmaktadır. Genellikle iki alternatif modeli karşılaştırırken, bu kriterlerden birinin daha küçük değerleri daha iyi bir modeli gösterir.

- Standart regresyon hatası, hata teriminin standart hatası olan σ tahminidir .

- Toplam karelerinin toplamı , kare model toplamı ve rezidüel kareler toplamı regresyon ile açıklanabilir nasıl numunede ilk varyasyonun çok bize.

- F-istatistiği , tüm katsayıların (kesme hariç) sıfıra eşit olduğu hipotezini test etmeye çalışır. Bu istatistik, sıfır hipotezi ve normallik varsayımı altında F ( p–1 , n–p ) dağılımına sahiptir ve p değeri , hipotezin gerçekten doğru olma olasılığını gösterir. Hatalar normal olmadığında bu istatistiğin geçersiz hale geldiğini ve Wald testi veya LR testi gibi diğer testlerin kullanılması gerektiğini unutmayın.

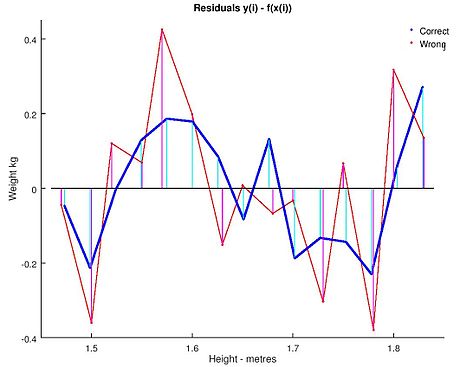

Olağan en küçük kareler analizi, genellikle, verilerin varsayılan model biçiminden sapmalarını tespit etmek için tasarlanmış tanılama grafiklerinin kullanımını içerir. Bunlar, yaygın tanılama grafiklerinden bazılarıdır:

- Modeldeki açıklayıcı değişkenlere karşı artıklar. Bu değişkenler arasındaki doğrusal olmayan bir ilişki, koşullu ortalama fonksiyonunun doğrusallığının geçerli olmayabileceğini gösterir. Açıklayıcı değişkenlerin farklı seviyeleri için artıklardaki farklı değişkenlik seviyeleri, olası değişen varyansı düşündürür.

- Modelde olmayan açıklayıcı değişkenlere karşı artıklar. Kalıntıların bu değişkenlerle herhangi bir ilişkisi, bu değişkenlerin modele dahil edilmesi için dikkate alınmasını önerir.

- Takılan değerlere karşı artıklar, .

- Önceki kalıntıya karşı kalıntılar. Bu çizim, artıklardaki seri korelasyonları tanımlayabilir.

Regresyon modellerini kullanarak istatistiksel çıkarım yaparken önemli bir husus, verilerin nasıl örneklendiğidir. Bu örnekte, veriler tek tek kadınlara ilişkin ölçümler yerine ortalamalardır. Modelin uyumu çok iyidir, ancak bu, bir kadının ağırlığının yalnızca boyuna dayalı olarak yüksek doğrulukla tahmin edilebileceği anlamına gelmez.

Yuvarlama duyarlılığı

Bu örnek ayrıca, bu hesaplamalarla belirlenen katsayıların, verilerin nasıl hazırlandığına duyarlı olduğunu da göstermektedir. Yükseklikler başlangıçta en yakın inç'e yuvarlatılmış olarak verilmiş ve dönüştürülmüş ve en yakın santimetreye yuvarlanmıştır. Dönüştürme faktörü bir inç ila 2,54 cm olduğundan, bu tam bir dönüşüm değildir . Orijinal inç, Round(x/0.0254) ile geri alınabilir ve daha sonra yuvarlamadan tekrar metriğe dönüştürülebilir. Bu yapılırsa sonuçlar şöyle olur:

| Sabit | Boy uzunluğu | Yükseklik 2 | |

|---|---|---|---|

| Yuvarlama ile metriğe dönüştürülür. | 128.8128 | -143.162 | 61.96033 |

| Yuvarlama yapılmadan metriğe dönüştürülür. | 119.0205 | -131.5076 | 58.5046 |

5' 6" (1.6764 m) bir kadının ağırlığını tahmin etmek için bu denklemlerden herhangi birinin kullanılması, benzer değerler verir: yuvarlatılmış 62.94 kg ve yuvarlamadan 62.98 kg. Dolayısıyla verilerdeki görünüşte küçük bir varyasyon katsayılar üzerinde gerçek bir etkiye sahiptir. ancak denklemin sonuçları üzerinde küçük bir etkisi vardır.

Bu, veri aralığının ortasında zararsız görünse de, uç noktalarda veya takılan modelin veri aralığının dışına yansıtmak için kullanıldığı ( ekstrapolasyon ) durumda önemli hale gelebilir .

Bu, yaygın bir hatayı vurgular: bu örnek, doğası gereği bağımsız değişkendeki (bu durumda yükseklik) hataların sıfır veya en azından ihmal edilebilir olmasını gerektiren OLS'nin kötüye kullanılmasıdır. En yakın inç'e ilk yuvarlama artı herhangi bir gerçek ölçüm hatası, sonlu ve ihmal edilemez bir hata oluşturur. Sonuç olarak, uydurulan parametreler tahmin edildikleri en iyi tahminler değildir. Tamamen sahte olmasa da, tahmindeki hata, x ve y hatalarının göreceli boyutuna bağlı olacaktır .

Daha az gerçek veri içeren başka bir örnek

Sorun bildirimi

Kutupsal taban koordinatlarında iki cisim yörüngesinin denklemini bulmak için en küçük kareler mekanizmasını kullanabiliriz. Tipik olarak kullanılan denklem , nesnenin gövdelerden birinden ne kadar uzakta olduğunun yarıçapının nerede olduğudur. Denklemde parametreler ve yörüngenin yolunu belirlemek için kullanılır. Aşağıdaki verileri ölçtük.

| (derece olarak) | 43 | 45 | 52 | 93 | 108 | 116 |

|---|---|---|---|---|---|---|

| 4.7126 | 4.5542 | 4.0419 | 2.2187 | 1.8910 | 1.7599 |

Verilen veriler için ve en küçük kareler yaklaşımını bulmamız gerekiyor .

Çözüm

İlk önce e ve p'yi doğrusal bir biçimde temsil etmemiz gerekiyor. O halde denklemi şu şekilde yeniden yazacağız . Şimdi bu formu gözlemsel verilerimizi şu şekilde temsil etmek için kullanabiliriz:

burada olduğu ve olduğu ve katsayısı; birinci kolon ile inşa edilir ve katsayısı olan ikinci bir kolon ve bir karşılık gelen değerleri So ve

Çözerken elde ederiz

yani ve

Ayrıca bakınız

- Bayes en küçük kareler

- Fama-MacBeth regresyonu

- Doğrusal olmayan en küçük kareler

- Doğrusal en küçük kareler için sayısal yöntemler

- Doğrusal olmayan sistem tanımlama

Referanslar

daha fazla okuma

- Dougherty, Christopher (2002). Ekonometriye Giriş (2. baskı). New York: Oxford University Press. s. 48–113. ISBN'si 0-19-877643-8.

- Gujarati, Damodar N. ; Porter, Şafak C. (2009). Temel Ekonomi (Beşinci baskı). Boston: McGraw-Hill Irwin. s. 55–96. ISBN'si 978-0-07-337577-9.

- Heij, Christian; Boer, Paul; Franses, Philip H.; Kloek, Teun; van Dijk, Herman K. (2004). İşletme ve Ekonomi Uygulamaları ile Ekonometrik Yöntemler (1. baskı). Oxford: Oxford University Press. s. 76–115. ISBN'si 978-0-19-926801-6.

- Hill, R. Carter; Griffiths, William E.; Lim, Guay C. (2008). Ekonometrinin İlkeleri (3. baskı). Hoboken, NJ: John Wiley & Sons. s. 8–47. ISBN'si 978-0-471-72360-8.

- Wooldridge, Jeffrey (2008). "Basit Regresyon Modeli" . Giriş Ekonometrisi: Modern Bir Yaklaşım (4. baskı). Mason, OH: Cengage Learning. s. 22–67. ISBN'si 978-0-324-58162-1.

![{\displaystyle \mathbf {x} _{i}=\left[x_{i1},x_{i2},\dots ,x_{ip}\sağ]^{\mathsf {T}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/daad19b2eabb379c5fce21e00f9e77f64b7a2808)

![[X\K]](https://wikimedia.org/api/rest_v1/media/math/render/svg/b0c7583e31f8e4111806d1612b81b39d3f76af01)

![\mathrm {E} {\big [}\,x_{i}(y_{i}-x_{i}^{T}\beta )\,{\big ]}=0.](https://wikimedia.org/api/rest_v1/media/math/render/svg/cb1a1f1cb2be7e80f44761892bf788fe2b2af548)

![{\displaystyle \operatöradı {E} [\,\varepsilon \mid X\,]=0.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dcdfa07f07180573874658708bc2a889d5416199)

![\Pr \!{\big [}\,\operatöradı {rütbe} (X)=p\,{\big ]}=1.](https://wikimedia.org/api/rest_v1/media/math/render/svg/6a11be3b89ce51c6441155fddbe512a991132fbf)

![\operatöradı {Var} [\,\varepsilon \mid X\,]=\sigma ^{2}I_{n},](https://wikimedia.org/api/rest_v1/media/math/render/svg/0df70427bd7e0b69175caf9150b2d465dd152474)

![\operatöradı {E} [\,{\hat {\beta }}\mid X\,]=\beta ,\quad \operatöradı {E} [\,s^{2}\mid X\,]=\sigma ^{2}.](https://wikimedia.org/api/rest_v1/media/math/render/svg/67bc2fd0f90c46da207712893fdcea01e729026c)

![{\displaystyle \operatorname {Var} [\,{\hat {\beta }}\mid X\,]=\sigma ^{2}(X^{T}X)^{-1}=\sigma ^{ 2}S.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f96b58e87986e32ad2375a1db34fb64a7a16e2f)

![\operatöradı {Cov} [\,{\hat {\beta }},{\hat {\varepsilon }}\mid X\,]=0.](https://wikimedia.org/api/rest_v1/media/math/render/svg/664c1a5e37957a1aa2ae381b9bcb07350c2c816c)

![\operatöradı {\beta}}[\,{\tilde {\beta }}\mid X\,]-\operatöradı {Var} [\,{\hat {\beta }}\mid X\,]\geq 0](https://wikimedia.org/api/rest_v1/media/math/render/svg/53796c9205889cc4d675b9749a58eb97fcd998f1)

![{\displaystyle \beta _{j}\in {\bigg [}\ {\hat {\beta }}_{j}\pm q_{1-{\frac {\alpha }{2}}}^{{ \mathcal {N}}(0,1)}\!{\sqrt {{\hat {\sigma }}^{2}\left[Q_{xx}^{-1}\sağ]_{jj}} }\ {\büyük ]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cf79688aac9f662ff39253fbfb0d234246d370e5)

![{\displaystyle ({\hat {\sigma }}^{2}-\sigma ^{2})\ {\xrightarrow {d}}\ {\mathcal {N}}\left(0,\;\operatöradı { E} \sol[\varepsilon _{i}^{4}\sağ]-\sigma ^{4}\sağ).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7c909dea2a4f0bf40e253680b953d1bfbb66298f)

![{\displaystyle y_{0}\in \sol[\ x_{0}^{\mathrm {T} }{\hat {\beta }}\pm q_{1-{\frac {\alpha }{2}} }^{{\mathcal {N}}(0,1)}\!{\sqrt {{\hat {\sigma }}^{2}x_{0}^{\mathrm {T} }Q_{xx} ^{-1}x_{0}}}\ \sağ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cf86d7a311c97d35fb6e039c3cd74bc9f3e752bf)

![{\displaystyle {\hat {\sigma }}_{j}=\left({\hat {\sigma }}^{2}\left[Q_{xx}^{-1}\sağ]_{jj} \sağ)^{\frac {1}{2}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5087e66171bf3ef9ad3ac75decdd715274919669)