Temel bileşenler Analizi - Principal component analysis

Temel bileşenler , bir noktalar topluluğu arasında gerçek koordinat alanında bir dizi olan birim vektörleri , inci vektör verileri olurken iyi uyan bir hat yönü dik birinci vektörler. Burada, en uygun çizgi, noktalardan çizgiye olan ortalama uzaklığın karesini en aza indiren bir çizgi olarak tanımlanır . Bu yönler , verilerin farklı bireysel boyutlarının doğrusal olarak ilişkisiz olduğu bir ortonormal temeli oluşturur . Temel bileşen analizi ( PCA ) temel bileşenlerin hesaplanması ve bazen yalnızca ilk birkaç temel bileşenin kullanılması ve geri kalanların göz ardı edilmesiyle veriler üzerinde bir temel değişikliği gerçekleştirmek için bunları kullanma sürecidir .

PCA, keşifsel veri analizinde ve tahmine dayalı modeller yapmak için kullanılır . Mümkün olduğu kadar çok veri varyasyonunu korurken, daha düşük boyutlu veriler elde etmek için her bir veri noktasını yalnızca ilk birkaç temel bileşene yansıtarak boyutluluğu azaltmak için yaygın olarak kullanılır . Birinci temel bileşen, öngörülen verilerin varyansını maksimize eden bir yön olarak eşdeğer olarak tanımlanabilir. İnci ana bileşen, birinci dik bir yön olarak alınabilir öngörülen veri sapmayı maksimize temel bileşenler.

Her iki amaçtan da, temel bileşenlerin , verilerin kovaryans matrisinin özvektörleri olduğu gösterilebilir . Bu nedenle, temel bileşenler genellikle veri kovaryans matrisinin özdekompozisyonu veya veri matrisinin tekil değer ayrıştırması ile hesaplanır. PCA, gerçek özvektör tabanlı çok değişkenli analizlerin en basitidir ve faktör analizi ile yakından ilişkilidir . Faktör analizi, tipik olarak, temel yapı hakkında daha alana özgü varsayımları içerir ve biraz farklı bir matrisin özvektörlerini çözer. PCA ayrıca kanonik korelasyon analizi (CCA) ile de ilgilidir . CCA, iki veri kümesi arasındaki çapraz kovaryansı en iyi şekilde tanımlayan koordinat sistemlerini tanımlarken , PCA, tek bir veri kümesindeki varyansı en iyi şekilde tanımlayan yeni bir ortogonal koordinat sistemi tanımlar . Standart PCA'nın sağlam ve L1-norm tabanlı varyantları da önerilmiştir.

Tarih

PCA, 1901'de Karl Pearson tarafından mekanikteki ana eksen teoreminin bir benzeri olarak icat edildi ; daha sonra bağımsız olarak geliştirildi ve 1930'larda Harold Hotelling tarafından adlandırıldı . Uygulama alanına bağlı olarak, aynı zamanda, ayrı olarak adlandırılır Karhunen-Loeve dönüşümü (KlT) sinyal işleme , Hotelling değişkenli kalite kontrol dönüşümü, uygun ortogonal ayrışma mekanik mühendislikte (POD), tekil değer ayrışımı arasında (SVD) X (19. yüzyılın son çeyreğinde icat edilmiştir), lineer cebirde X T X'in özdeğer ayrıştırması (EVD) , faktör analizi (PCA ve faktör analizi arasındaki farkların bir tartışması için Jolliffe'in Temel Bileşen Analizi , Bölüm 7'ye bakınız ), Eckart–Young teoremi (Harman, 1960) veya meteoroloji biliminde ampirik ortogonal fonksiyonlar (EOF), ampirik özfonksiyon ayrıştırması (Sirovich, 1987), ampirik bileşen analizi (Lorenz, 1956), yarı harmonik modlar (Brooks ve diğerleri, 1988), gürültü ve titreşimde spektral ayrışma ve yapısal dinamikte ampirik modal analiz .

Sezgi

PCA, elipsoidin her ekseninin bir ana bileşeni temsil ettiği, verilere p boyutlu bir elipsoid uydurma olarak düşünülebilir . Elipsoidin bir ekseni küçükse, o eksen boyunca varyans da küçüktür.

Elipsoidin eksenlerini bulmak için, verileri orijin etrafında ortalamak için önce her değişkenin ortalamasını veri kümesinden çıkarmalıyız. Ardından, verilerin kovaryans matrisini hesaplıyoruz ve bu kovaryans matrisinin özdeğerlerini ve karşılık gelen özvektörlerini hesaplıyoruz. O zaman onları birim vektörlere dönüştürmek için ortogonal özvektörlerin her birini normalleştirmeliyiz. Bu yapıldıktan sonra, karşılıklı olarak ortogonal, birim özvektörlerin her biri, verilere uyan elipsoidin bir ekseni olarak yorumlanabilir. Bu temel seçimi, kovaryans matrisimizi, her eksenin varyansını temsil eden köşegen elemanlarla köşegenleştirilmiş bir forma dönüştürecektir. Her bir özvektörün temsil ettiği varyansın oranı, o özvektöre karşılık gelen özdeğerin tüm özdeğerlerin toplamına bölünmesiyle hesaplanabilir.

Detaylar

PCA, verileri yeni bir koordinat sistemine dönüştüren dikey bir doğrusal dönüşüm olarak tanımlanır; öyle ki, verilerin bazı skaler izdüşümleriyle en büyük varyans birinci koordinatta (birinci ana bileşen olarak adlandırılır), ikinci en büyük varyans ise koordinat üzerinde bulunur. ikinci koordinat, vb.

Bir göz önünde veri matrisi , X kolon-bazlı sıfır ile, deneysel ortalama her biri (sıfır kaymıştır, her bir sütunun örnek ortalaması) n, satır deney farklı bir tekrarını temsil etmektedir, ve her bir p sütun bir verir belirli bir tür özellik (örneğin, belirli bir sensörün sonuçları).

Matematiksel olarak, transformasyon boyutta bir kümesi tarafından tanımlanmaktadır ve p ağırlıkları ya da katsayıların boyutlu vektörler her satır vektör haritası arasında X ana bileşeni yeni bir vektöre skorları , verilen

öyle bir şekilde ki, veri seti üzerinde düşünülen t'nin bireysel değişkenleri , X'den olası maksimum varyansı art arda miras alır, her katsayı vektörü w bir birim vektör olarak sınırlandırılır (burada genellikle boyutluluğu azaltmaktan daha az olarak seçilir ).

İlk bileşen

Varyansı maksimize etmek için, birinci ağırlık vektörü w (1) bu nedenle

Eşdeğer olarak, bunu matris formunda yazmak şunu verir:

Yana ağırlık (1) , bu eşdeğer da tatmin bir birim vektörü olarak tanımlanmıştır

Maksimize edilecek miktar bir Rayleigh bölümü olarak kabul edilebilir . X T X gibi pozitif bir yarı tanımlı matris için standart bir sonuç , bölümün mümkün olan maksimum değerinin, w karşılık gelen özvektör olduğunda ortaya çıkan matrisin en büyük öz değeri olmasıdır .

İle ağ (1) bulunan bir veri vektörü birinci ana bileşeni x ( i ) daha sonra, bir skor olarak verilebilir t 1 ( i ) = x ( i ) ⋅ w (1) dönüştürülmüş koordinatlar, ya da orijinal değişkenlerde karşılık gelen vektör, { x ( i ) ⋅ w (1) } w (1) .

Diğer bileşenler

K inci bileşen, birinci çıkarılarak bulunabilir k - 1 ana bileşeni X :

ve sonra bu yeni veri matrisinden maksimum varyansı çıkaran ağırlık vektörünü bulmak

Bunun , karşılık gelen özdeğerleri tarafından verilen parantez içindeki miktar için maksimum değerlerle birlikte X T X'in kalan özvektörlerini verdiği ortaya çıktı . Dolayısıyla ağırlık vektörleri, X T X'in özvektörleridir .

K veri vektörü inci ana bileşen x ( i ) , bu nedenle bir skor olarak verilebilir t k ( i ) = x ( i ) ⋅ w ( k ), transforme edilmiş koordinatlara göre ya da boşluk karşılık gelen vektör olarak orijinal değişkenler, { x ( i ) ⋅ w ( k ) } w ( k ) , ağırlık ( k ) olduğu k inci özvektörün X , T x .

Bu nedenle X'in tam temel bileşenlerinin ayrışması şu şekilde verilebilir:

burada W , sütunları X T X'in özvektörleri olan bir p- by- p ağırlık matrisidir . W'nin devrik bazen beyazlatma veya küre dönüşümü olarak adlandırılır . Karşılık gelen özdeğerlerin karekökü ile çarpılan W sütunlarına , yani varyanslarla büyütülen özvektörlere , PCA'da veya Faktör analizinde yüklemeler denir .

kovaryanslar

X T X'in kendisi, X T veri kümesinin deneysel örnek kovaryans matrisiyle orantılı olarak tanınabilir .

Veri kümesi üzerindeki iki farklı temel bileşen arasındaki örnek kovaryans Q şu şekilde verilir:

burada w ( k ) özdeğer özelliği 2. satırdan 3. satıra geçmek için kullanılmıştır. Ancak simetrik bir matrisin özdeğerlerine karşılık gelen w ( j ) ve w ( k ) özvektörleri ortogonaldir (eğer özdeğerler farklıysa) veya ortogonalize edilebilir (eğer vektörler eşit bir tekrarlanan değeri paylaşıyorsa). Bu nedenle son satırdaki ürün sıfırdır; veri kümesi üzerinde farklı temel bileşenler arasında örnek kovaryans yoktur.

Bu nedenle, temel bileşenler dönüşümünü karakterize etmenin bir başka yolu, deneysel örnek kovaryans matrisini köşegenleştiren koordinatlara dönüşümdür.

Matris formunda, orijinal değişkenler için ampirik kovaryans matrisi yazılabilir.

Temel bileşenler arasındaki ampirik kovaryans matrisi,

burada Λ özdeğerler diyagonal matris λ ( k ) arasında X- T , X . λ ( k ) her bir k bileşeniyle ilişkili veri kümesi üzerindeki karelerin toplamına eşittir , yani λ ( k ) = Σ ben t k 2 ( i ) = Σ ben ( x ( i ) ⋅ w ( k ) ) 2 .

Boyutsal küçülme

Dönüşüm , T = X W veri vektörü haritalar x ( i ) bir orijinal boşluğundan s yeni bir alana değişken s veri kümesi üzerinde ilintisiz değişkenler. Ancak, tüm temel bileşenlerin saklanması gerekmez. Yalnızca ilk L özvektörleri kullanılarak üretilen yalnızca ilk L temel bileşenlerini tutmak , kesik dönüşümü verir.

T L matrisinin artık n satırı olduğu ancak yalnızca L sütunu olduğu yerde. Başka bir deyişle, PCA , p × L matrisinin sütunlarının , ilişkisiz olan L özellikleri ( t temsilinin bileşenleri ) için ortogonal bir temel oluşturduğu bir doğrusal dönüşüm öğrenir . Yalnızca L sütunlu tüm dönüştürülmüş veri matrislerinin yapılandırılmasıyla, bu puan matrisi, korunan orijinal verilerdeki varyansı en üst düzeye çıkarırken, toplam kare yeniden oluşturma hatasını veya .

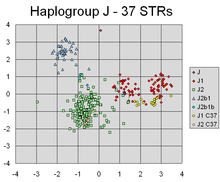

PCA, bireylerin Y-kromozomal genetik kökenlerinin farklı hatlarına karşılık gelen farklı kümeleri ayıran farklı belirteçlerin doğrusal kombinasyonlarını başarıyla buldu.

Bu tür boyutluluk azaltma , yüksek boyutlu veri kümelerini görselleştirmek ve işlemek için çok yararlı bir adım olabilirken, yine de veri kümesindeki varyansın mümkün olduğunca çoğunu korur. Örneğin, L = 2'yi seçmek ve yalnızca ilk iki ana bileşeni tutmak, verilerin en çok yayıldığı yüksek boyutlu veri kümesi boyunca iki boyutlu düzlemi bulur, bu nedenle veriler kümeler içeriyorsa bunlar da en çok yayılmış olabilir, ve bu nedenle iki boyutlu bir diyagramda çizilmek üzere en görünür; oysa verilerde iki yön (veya orijinal değişkenlerden ikisi) rasgele seçilirse, kümeler birbirinden çok daha az dağılmış olabilir ve aslında büyük ölçüde birbirinin üzerine binerek onları ayırt edilemez hale getirme olasılığı çok daha yüksek olabilir.

Benzer şekilde, regresyon analizinde , izin verilen açıklayıcı değişkenlerin sayısı ne kadar fazlaysa, modele gereğinden fazla uyma ve diğer veri kümelerine genellemeyen sonuçlar üretme şansı o kadar artar . Bir yaklaşım, özellikle farklı olası açıklayıcı değişkenler arasında güçlü korelasyonlar olduğunda, bunları birkaç temel bileşene indirgemek ve daha sonra bunlara karşı regresyonu çalıştırmaktır, bu yöntem ana bileşen regresyonu olarak adlandırılır .

Bir veri kümesindeki değişkenler gürültülü olduğunda, boyutsallık azaltma da uygun olabilir. Veri kümesinin her bir sütunu bağımsız, özdeş olarak dağıtılmış Gauss gürültüsü içeriyorsa, o zaman T'nin sütunları da benzer şekilde özdeş olarak dağıtılmış Gauss gürültüsü içerecektir (böyle bir dağılım, yüksek boyutlu olarak düşünülebilecek W matrisinin etkileri altında değişmezdir). koordinat eksenlerinin dönüşü). Bununla birlikte, aynı gürültü varyansına kıyasla ilk birkaç ana bileşende yoğunlaşan toplam varyansın daha fazlası ile, gürültünün orantılı etkisi daha azdır - ilk birkaç bileşen daha yüksek bir sinyal-gürültü oranı elde eder . Böylece PCA, sinyalin çoğunu, boyutsallık indirgemesi ile faydalı bir şekilde yakalanabilen ilk birkaç temel bileşene yoğunlaştırma etkisine sahip olabilir; daha sonraki ana bileşenlere gürültü hakim olabilir ve bu nedenle büyük bir kayıp olmadan bertaraf edilebilir. Veri kümesi çok büyük değilse, kaç temel bileşenin tutulacağını belirlemeye yardımcı olmak için temel bileşenlerin önemi parametrik önyükleme kullanılarak test edilebilir .

Tekil değer ayrışımı

Ana bileşenler dönüşüm aynı zamanda başka bir matris çarpanlara ile ilişkili olabilir, tekil değer ayrışımı arasında (SVD) X ,

Burada Σ , X'in tekil değerleri olarak adlandırılan, pozitif sayıların σ ( k ) 'den oluşan bir n'ye - p dikdörtgen diyagonal matrisidir ; U bir bir n -by- N matrisi, uzunluk ortogonal birim vektörleri olan sütunları N sol tekil vektörleri denir X ; ve W , sütunları p uzunluğundaki ortogonal birim vektörleri olan ve X'in sağ tekil vektörleri olarak adlandırılan bir p- by- p'dir .

Bu çarpanlara ayırma açısından, X T X matrisi yazılabilir.

X'in tekil değerlerine sahip kare köşegen matris nerede ve bunu sağlayan fazla sıfırlar . Özvektörü çarpanlara ile karşılaştırma X , T , X doğru tekil vektörler bu kurar W arasında X özvektörleri eşdeğerdir X , T , X , tekil değerlerin ise σ ( k ) arasında Özdeğerlerin kare köküne eşittir λ ( k ) arasında X, T , X .

Tekil değer ayrıştırması kullanılarak T skor matrisi yazılabilir.

dolayısıyla T'nin her sütunu, X'in sol tekil vektörlerinden biri ile karşılık gelen tekil değerin çarpımı ile verilir. Bu şekilde aynı zamanda polar bir ayrışma arasında T .

X'in SVD'sini X T X matrisini oluşturmak zorunda kalmadan hesaplamak için etkin algoritmalar mevcuttur , bu nedenle SVD'yi hesaplamak, yalnızca bir avuç bileşen gerekmedikçe, artık bir veri matrisinden bir temel bileşen analizini hesaplamanın standart yoludur.

Eigen-bozunma ile birlikte olduğu gibi, bir kesik N x L puanı matrisi T L , yalnızca ilk L büyük tekil değerler ve tekil vektörler dikkate alınarak elde edilebilir:

Bu şekilde bir kesik tekil değer ayrıştırması kullanılarak bir M veya T matrisinin kesilmesi, mümkün olan en küçük Frobenius normuna sahip ikisi arasındaki fark anlamında, orijinal matrise en yakın olası L dereceli matris olan bir kesik matris üretir. , Eckart-Young teoremi [1936] olarak bilinen bir sonuç.

Diğer hususlar

Öklid uzayında bir dizi nokta verildiğinde , birinci temel bileşen, çok boyutlu ortalamadan geçen ve noktaların çizgiden uzaklıklarının karelerinin toplamını en aza indiren bir çizgiye karşılık gelir. Birinci temel bileşenle olan tüm korelasyon noktalardan çıkarıldıktan sonra, ikinci temel bileşen aynı kavrama karşılık gelir. Tekil değerler ( Σ cinsinden), X T X matrisinin öz değerlerinin kare kökleridir . Her özdeğer, her bir özvektörle ilişkili "varyans"ın (çok boyutlu ortalamalarından noktaların uzaklıklarının karelerinin toplamının daha doğrusu) kısmıyla orantılıdır. Tüm özdeğerlerin toplamı, noktaların çok boyutlu ortalamalarından uzaklıklarının karelerinin toplamına eşittir. PCA, temel bileşenlerle hizalanmak için esas olarak nokta kümesini ortalamaları etrafında döndürür. Bu, varyansın mümkün olduğunca çoğunu (bir ortogonal dönüşüm kullanarak) ilk birkaç boyuta taşır. Bu nedenle, kalan boyutlardaki değerler küçük olma eğilimindedir ve minimum bilgi kaybıyla düşürülebilir (aşağıya bakınız ). PCA genellikle bu şekilde boyut azaltma için kullanılır . PCA, en büyük "varyansa" (yukarıda tanımlandığı gibi) sahip olan alt uzayı tutmak için en uygun ortogonal dönüşüm olma ayrıcalığına sahiptir. Bununla birlikte, bu avantaj, örneğin ve uygulanabilir olduğunda, ayrık kosinüs dönüşümüyle ve özellikle basitçe "DCT" olarak bilinen DCT-II ile karşılaştırıldığında, daha büyük hesaplama gereksinimleri pahasına gelir . Doğrusal olmayan boyut indirgeme teknikleri, PCA'dan daha fazla hesaplama gerektirme eğilimindedir.

PCA, değişkenlerin ölçeklenmesine duyarlıdır. Eğer sadece iki değişkenimiz varsa ve bunlar aynı örnek varyansına sahiplerse ve pozitif korelasyona sahiplerse, o zaman PCA esasa göre iki değişken için 45°'lik bir dönüş ve "ağırlıklar" (bunlar dönmenin kosinüsleridir) gerektirecektir. bileşen eşit olacaktır. Ancak ilk değişkenin tüm değerlerini 100 ile çarparsak, o zaman ilk temel bileşen, diğer değişkenin küçük bir katkısıyla o değişkenle hemen hemen aynı olacak, ikinci bileşen ise ikinci orijinal değişkenle neredeyse aynı hizada olacaktır. Bu, farklı değişkenler farklı birimlere sahip olduğunda (sıcaklık ve kütle gibi), PCA'nın biraz keyfi bir analiz yöntemi olduğu anlamına gelir. (Örneğin, Santigrat yerine Fahrenheit kullanılırsa farklı sonuçlar elde edilebilir.) Pearson'ın orijinal makalesi "On Lines and Planes of Lines of Closest Systems of Points of Systems" (Uzaydaki Nokta Sistemlerine En Yakın Uydurma Düzlemler) başlığını taşıyordu – "uzayda", bu tür kaygıların olduğu yerde fiziksel Öklid uzayını ifade eder. ortaya çıkmaz. PCA'yı daha az keyfi hale getirmenin bir yolu, verileri standartlaştırarak birim varyansa sahip olacak şekilde ölçeklenen değişkenleri kullanmak ve dolayısıyla PCA için bir temel olarak otokovaryans matrisi yerine otokorelasyon matrisini kullanmaktır. Ancak bu, sinyal uzayının tüm boyutlarındaki dalgalanmaları birim varyansa sıkıştırır (veya genişletir).

İlk temel bileşenin maksimum varyans yönünü tanımlamasını sağlamak için klasik PCA gerçekleştirmek için ortalama çıkarma (aka "ortalama merkezleme") gereklidir. Ortalama çıkarma işlemi gerçekleştirilmezse, bunun yerine birinci temel bileşen, verinin ortalamasına aşağı yukarı karşılık gelebilir. Verilerin yaklaşıklığının ortalama kare hatasını en aza indiren bir temel bulmak için bir ortalama sıfır gereklidir .

Veriler zaten korelasyonlar hesaplandıktan sonra ortalandığından, bir korelasyon matrisi üzerinde bir temel bileşen analizi gerçekleştiriliyorsa ortalama merkezleme gereksizdir. Korelasyonlar, iki standart puanın (Z-puanları) veya istatistiksel momentlerin (dolayısıyla adı: Pearson Çarpımı-Moment Korelasyonu ) çapraz ürününden türetilir . Ayrıca Kromrey & Foster-Johnson'ın (1998) "Moderated Regresyonda Ortalama Merkezleme: Hiçbir Şey Hakkında Çok Ado" başlıklı makalesine bakın .

PCA, örüntü tanımada popüler bir birincil tekniktir . Bununla birlikte, sınıf ayrılabilirliği için optimize edilmemiştir. Bununla birlikte, temel bileşen uzayında her sınıf için kütle merkezi hesaplanarak ve iki veya daha fazla sınıfın kütle merkezi arasındaki Öklid mesafesini bildirerek iki veya daha fazla sınıf arasındaki mesafeyi ölçmek için kullanılmıştır. Doğrusal ayırma analizi sınıfı ayrılabilen için optimize edilmiş bir alternatiftir.

Semboller ve kısaltmalar tablosu

| Sembol | Anlam | Boyutlar | Endeksler |

|---|---|---|---|

| satır başına bir vektör olmak üzere tüm veri vektörlerinin kümesinden oluşan veri matrisi |

|

||

| veri kümesindeki satır vektörlerinin sayısı | skaler | ||

| her satır vektöründeki eleman sayısı (boyut) | skaler | ||

| boyutsal olarak indirgenmiş alt uzaydaki boyutların sayısı, | skaler | ||

| ampirik araçların vektörü , veri matrisinin her j sütunu için bir ortalama | |||

| ampirik standart sapmaların vektörü , veri matrisinin her j sütunu için bir standart sapma | |||

| tüm 1'lerin vektörü | |||

| veri matrisinin her bir j sütununun ortalamasından sapmalar |

|

||

| veri matrisinin her m satırı için ortalama ve standart sapma kullanılarak hesaplanan z puanları |

|

||

| kovaryans matrisi |

|

||

| korelasyon matrisi |

|

||

| Matris tüm grubu aşağıdakilerden oluşan özvektörler ve C , kolon başına bir özvektörü |

|

||

| diyagonal matris tüm grubu aşağıdakilerden oluşan özdeğerler ve C kendi boyunca ana Diagonal diğer tüm elemanları, ve 0 |

|

||

| Her bir temel vektör özvektörleri biri olan taban vektörleri, kolon başına bir vektör, bir matris C vektörler burada ve W bu bir alt grubu olan V |

|

||

| n satır vektöründen oluşan matris , burada her vektör, X matrisinden karşılık gelen veri vektörünün W matrisinin sütunlarında bulunan temel vektörlere izdüşümüdür . |

|

PCA'nın özellikleri ve sınırlamaları

Özellikler

PCA'nın bazı özellikleri şunları içerir:

-

Özellik 1 : Herhangi birq, 1 ≤q≤ptamsayı için, ortogonallineer dönüşümügöz önünde bulundurun

- nerede bir q-eleman vektörüdür ve bir ( q × p ) matrisidir ve için varyans - kovaryans matrisi olsun . Daha sonra iz gösterilen, alarak maksimize edilir burada, birinci oluşur q, sütun aktarılması olan .

-

Özellik 2 : Birdik dönüşümütekrar düşünün

- ile ve daha önce olduğu gibi tanımlanmıştır. Daha sonra , son q sütunlarından oluştuğu yeri alarak minimize edilir .

Bu özelliğin istatistiksel anlamı, son birkaç PC'nin, önemli PC'leri çıkardıktan sonra yapılandırılmamış arta kalanlar olmadığıdır. Bu son PC'ler mümkün olduğunca küçük farklılıklara sahip olduklarından, kendi başlarına faydalıdırlar. Bunlar unsurları arasındaki ilişkileri doğrusal umulmadık yakın sabit tespit etmek için yardımcı olabilir , x , ve aynı zamanda da yararlı olabilir regresyon değişkenlerin bir alt kümesini seçerek, x , ve aşırı uç tespiti.

-

Özellik 3 : ( Σ 'nin spektral ayrışması)

Kullanımına bakmadan önce köşegen elemanlara bakarız ,

O zaman, belki de sonucun ana istatistiksel anlamı, yalnızca x'in tüm öğelerinin birleşik varyanslarını her bir PC'ye bağlı azalan katkılara ayrıştırmakla kalmayıp, aynı zamanda tüm kovaryans matrisini her bir PC'den gelen katkılara ayrıştırabileceğimizdir . Tam olarak azalmasa da , iradenin öğeleri, artan için artmadığı gibi , arttıkça küçülme eğilimi gösterirken, öğelerin normalleştirme kısıtlamaları nedeniyle yaklaşık olarak aynı boyutta kalma eğilimi vardır: .

sınırlamalar

Yukarıda belirtildiği gibi, PCA'nın sonuçları değişkenlerin ölçeklenmesine bağlıdır. Bu, her bir özelliği standart sapmasına göre ölçeklendirerek iyileştirilebilir, böylece birim varyanslı boyutsuz özellikler elde edilir.

Yukarıda açıklandığı gibi PCA'nın uygulanabilirliği, türetilmesinde yapılan belirli (zımni) varsayımlarla sınırlıdır. Özellikle, PCA, özellikler arasındaki doğrusal korelasyonları yakalayabilir, ancak bu varsayım ihlal edildiğinde başarısız olur (referanstaki Şekil 6a'ya bakın). Bazı durumlarda, koordinat dönüşümleri doğrusallık varsayımını geri yükleyebilir ve daha sonra PCA uygulanabilir (bakınız çekirdek PCA ).

Diğer bir sınırlama, PCA için kovaryans matrisini oluşturmadan önce ortalama çıkarma işlemidir. Astronomi gibi alanlarda, tüm sinyaller negatif değildir ve ortalama kaldırma işlemi, bazı astrofiziksel maruziyetlerin ortalamasını sıfır olmaya zorlar, bu da sonuç olarak fiziksel olmayan negatif akışlar yaratır ve gerçek olanı kurtarmak için ileri modelleme yapılmalıdır. sinyallerin büyüklüğü. Alternatif bir yöntem olarak, astrofiziksel gözlemler için çok uygun olan, yalnızca matrislerdeki negatif olmayan öğelere odaklanan negatif olmayan matris çarpanlarına ayırma . PCA ve Negatif Olmayan Matris Çarpanlara ayırma arasındaki ilişkide daha fazlasını görün .

PCA uygulanmadan önce veriler standartlaştırılmamışsa PCA bir dezavantajdır. PCA, orijinal verileri, bu verilerin temel bileşenleriyle ilgili verilere dönüştürür; bu, yeni veri değişkenlerinin orijinallerle aynı şekilde yorumlanamayacağı anlamına gelir. Orijinal değişkenlerin doğrusal yorumlarıdır. Ayrıca, PCA düzgün bir şekilde gerçekleştirilmezse, yüksek bir bilgi kaybı olasılığı vardır.

PCA doğrusal bir modele dayanır. Bir veri kümesinin içinde doğrusal olmayan bir desen gizliyse, PCA aslında analizi ilerlemenin tam tersi yönünde yönlendirebilir. Kansas Eyalet Üniversitesi'ndeki araştırmacılar, deneylerindeki örnekleme hatasının PCA sonuçlarının yanlılığını etkilediğini keşfetti. "Eğer deneklerin veya blokların sayısı 30'dan küçükse ve/veya araştırmacı birincinin ötesindeki PC'lerle ilgileniyorsa, PCA yapılmadan önce seri korelasyonu düzeltmek daha iyi olabilir". Kansas Eyaletindeki araştırmacılar ayrıca PCA'nın "verilerin otokorelasyon yapısı doğru şekilde ele alınmazsa ciddi şekilde önyargılı olabileceğini" buldular.

PCA ve bilgi teorisi

Boyut azaltma, genel olarak bilgiyi kaybeder. PCA tabanlı boyut azaltma, belirli sinyal ve gürültü modelleri altında bu bilgi kaybını en aza indirme eğilimindedir.

olduğu varsayımı altında

yani, veri vektörü , istenen bilgi taşıyan sinyalin ve bir gürültü sinyalinin toplamıdır, bir bilgi-teorik bakış açısından, PCA'nın boyut indirgemesi için optimal olabileceğini gösterebilir.

Özellikle, Linsker, eğer Gauss ise ve kimlik matrisiyle orantılı bir kovaryans matrisi ile Gauss gürültüsü ise, PCA'nın istenen bilgi ile boyutsallığı azaltılmış çıktı arasındaki karşılıklı bilgiyi maksimize ettiğini gösterdi .

Gürültü hala Gauss ve varsa, bir kovaryans matrisi orantılı kimlik matrisine (olup, vektörün bileşenleri olan IID ), ancak bu bilgiler taşıyan sinyali , en azından, PCA (yaygın bir senaryo) olmayan Gaussian olarak tanımlanan bilgi kaybının üst sınırını en aza indirir

PCA'nın optimalliği, gürültünün iid olması ve en azından bilgi taşıyan sinyalden daha fazla Gauss ( Kullback-Leibler ayrışması açısından) olması durumunda da korunur . Genel olarak, yukarıdaki sinyal modeli geçerli olsa bile, PCA, gürültü bağımlı hale gelir gelmez bilgi-teorik optimalliğini kaybeder .

Kovaryans yöntemini kullanarak PCA'nın hesaplanması

Aşağıda, korelasyon yönteminin aksine kovaryans yöntemini (ayrıca buraya bakınız ) kullanan PCA'nın ayrıntılı bir açıklaması yer almaktadır .

Amaç, p boyutunun belirli bir X veri kümesini daha küçük L boyutuna sahip alternatif bir Y veri kümesine dönüştürmektir . Eşdeğer olarak, Y matrisini bulmaya çalışıyoruz , burada Y , X matrisinin Karhunen–Loève dönüşümüdür (KLT) :

- Veri kümesini düzenleyin

Bir dizi p değişkeni gözleminden oluşan verileriniz olduğunu ve her bir gözlemin yalnızca L değişkenleri, L < p ile tanımlanabilmesi için verileri azaltmak istediğinizi varsayalım . Ayrıca, verilerin, her biri p değişkenlerinin tek bir gruplanmış gözlemini temsil eden bir dizi n veri vektörü olarak düzenlendiğini varsayalım .

- Her biri p elemanlı satır vektörleri olarak yazın .

- Satır vektörlerini n × p boyutlarında tek bir X matrisine yerleştirin .

- Ampirik ortalamayı hesaplayın

- Her j = 1, ..., p sütunu boyunca ampirik ortalamayı bulun .

- Hesaplanan ortalama değerleri, p × 1 boyutlarının ampirik ortalama vektörü u'ya yerleştirin .

- Ortalamadan sapmaları hesaplayın

Ortalama çıkarma, verilere yaklaşmanın ortalama kare hatasını en aza indiren bir temel bileşen temeli bulmaya yönelik çözümün ayrılmaz bir parçasıdır. Bu nedenle, verileri aşağıdaki gibi ortalayarak ilerliyoruz:

- X veri matrisinin her satırından ampirik ortalama vektörü çıkarın .

- Ortalama çıkarılmış verileri n × p matrisi B'de saklayın .

- burada h , bir olduğu , n x 1 tümü 1 kolon vektörü:

Bazı uygulamalarda, her değişken ( B sütunu ) 1'e eşit bir varyansa sahip olacak şekilde ölçeklenebilir (bkz. Z-skoru ). Bu adım, hesaplanan temel bileşenleri etkiler, ancak onları farklı değişkenleri ölçmek için kullanılan birimlerden bağımsız kılar.

- Kovaryans matrisini bulun

- Bul p x s ampirik kovaryans matrisi Cı matrisi B :burada bir eşlenik devrik operatörü. Eğer B birçok uygulamada olduğu gerçek sayılar, tamamen oluşur "eşlenik devrik" normal aynıdır devrik .

- Kovaryansı hesaplamak için n yerine n − 1 kullanmanın ardındaki mantık Bessel'in düzeltmesidir .

- Kovaryans matrisinin özvektörlerini ve özdeğerlerini bulun

- Matris hesaplamak V bölgesinin özvektörler köşegenleştirir kovaryans matrisi C :burada D bir köşegen matris arasında eigen arasında C . Bu adım, tipik olarak, özvektörleri ve özdeğerleri hesaplamak için bilgisayar tabanlı bir algoritmanın kullanımını içerecektir . Bu algoritmalar SAS , R , MATLAB , Mathematica , SciPy , IDL ( Etkileşimli Veri Dili ) veya GNU Octave ve OpenCV gibi çoğu matris cebir sisteminin alt bileşenleri olarak kolayca mevcuttur .

- Matris D bir biçimini alacaktır p'nin x s diyagonal matris,olan j kovaryans matris özdeğer inci Cı ve

- Matris V , aynı zamanda boyut, s x p içerir s kolon vektörleri, uzunluk her bir p temsil s kovaryans matrisi vektörlerini Cı .

- Özdeğerler ve özvektörler sıralanır ve eşleştirilir. J th özdeğer tekabül j özvektör inci.

- Matris V , sağ özvektörlerin matrisini gösterir ( sol özvektörlerin aksine ). Genel olarak, hemen özvektörlerin matris gerek olmayan kalan özvektörler matrisi (konjugat) devrik olabilir.

- Özvektörleri ve özdeğerleri yeniden düzenleyin

- Özvektör matrisi V ve özdeğer matrisi D' nin sütunlarını azalan özdeğer sırasına göre sıralayın .

- Her matristeki sütunlar arasında doğru eşleşmeleri sağladığınızdan emin olun.

- Her özvektör için kümülatif enerji içeriğini hesaplayın

- Özdeğerler, kaynak verilerin enerjisinin özvektörlerin her biri arasında dağılımını temsil eder, burada özvektörler veriler için bir temel oluşturur. j özvektörü için kümülatif enerji içeriği g , 1'den j'ye kadar tüm özdeğerlerdeki enerji içeriğinin toplamıdır :

- Temel vektörler olarak özvektörlerin bir alt kümesini seçin

- V'nin ilk L sütunlarını p × L matrisi W olarak kaydedin :nerede

- L için uygun bir değer seçerken kılavuz olarak g vektörünü kullanın . Amaç, yüzde bazında oldukça yüksek bir g değeri elde ederken mümkün olduğunca küçük bir L değeri seçmektir . Örneğin , kümülatif enerji g'nin yüzde 90 gibi belirli bir eşiğin üzerinde olması için L' yi seçmek isteyebilirsiniz . Bu durumda, L' nin en küçük değerini şu şekilde seçin:

- Verileri yeni temele yansıtın

- Öngörülen veri noktaları matrisin satırlarıdır

Yani, birinci sütun , veri noktalarının birinci ana bileşen üzerine izdüşümü, ikinci sütun, ikinci ana bileşen üzerine izdüşümdür, vb.

Kovaryans yöntemi kullanılarak PCA'nın türetilmesi

Let X, bir olmak d sütun matrisi olarak ifade boyutlu rasgele vektör. Genelliği kaybetmeden, X'in sıfır ortalaması olduğunu varsayalım .

Bir d × d ortonormal dönüşüm matrisi P bulmak istiyoruz, böylece PX bir diyagonal kovaryans matrisine sahip olur (yani, PX , tüm farklı bileşenleri çift olarak ilişkisiz olan rastgele bir vektördür).

Üniter verimler olduğunu varsayan hızlı bir hesaplama :

Bu nedenle , ancak ve ancak tarafından köşegenleştirilebilirse geçerlidir .

cov( X )'in negatif olmayan belirli bir matris olması ve dolayısıyla bazı üniter matrisler tarafından köşegenleştirilebilir olması garanti edildiğinden , bu çok yapıcıdır .

Kovaryanssız hesaplama

Pratik uygulamalarda, özellikle yüksek boyutlu verilerle (büyük p ), kovaryans matrisini açıkça belirlemenin yüksek hesaplama ve bellek maliyetleri nedeniyle verimli olmadığı için saf kovaryans yöntemi nadiren kullanılır. Kovaryanssız yaklaşım, X T X kovaryans matrisini açıkça hesaplama ve saklama np 2 işlemlerinden kaçınır , bunun yerine matris içermeyen yöntemlerden birini kullanır , örneğin, X T (X r) ürününü maliyette değerlendiren fonksiyona dayalıdır. arasında 2 np işlemleri.

yinelemeli hesaplama

Birinci temel bileşeni verimli bir şekilde hesaplamanın bir yolu , kovaryans matrisini hiç hesaplamadan sıfır ortalamalı bir veri matrisi X için aşağıdaki sözde kodda gösterilmiştir .

r = a random vector of length p r = r / norm(r) do c times: s = 0 (a vector of length p) for each row x in X s = s + (x ⋅ r) x λ = rTs // λ is the eigenvalue error = |λ ⋅ r − s| r = s / norm(s) exit if error < tolerance return λ, r

Bu güç yineleme algoritması, X T (X r) vektörünü basitçe hesaplar , normalleştirir ve sonucu tekrar r'ye yerleştirir . Özdeğer, kovaryans matrisi X T X için birim vektör r üzerindeki Rayleigh bölümü olan r T (X T X) r ile yaklaşık olarak hesaplanır . En tekil değer de büyük bir sonraki ayrı ise, vektör, r, yakın birinci temel bileşene alır X yineleme sayısı içinde c göre küçük olduğu, p toplam maliyeti, 2cnp . Güç yineleme yakınsama belirgin bir şekilde daha ileri kullanılarak yineleme başına küçük bir maliyet ödün vermeden hızlandırılabilir matris içermeyen yöntemler gibi, Lanczos algoritması ya da yerel olarak en uygun blok ön şartlandırılmış Eşlenik Gradyan ( LOBPCG ) yöntemi.

Müteakip ana bileşenler, tek tek deflasyon yoluyla veya aynı anda bir blok olarak hesaplanabilir. Önceki yaklaşımda, önceden hesaplanmış yaklaşık temel bileşenlerdeki belirsizlikler, daha sonra hesaplanan temel bileşenlerin doğruluğunu ek olarak etkiler, böylece her yeni hesaplamada hatayı artırır. Blok gücü yöntemindeki ikinci yaklaşım, tekli r ve s vektörlerini blok vektörler, R ve S matrisleri ile değiştirir . R'nin her sütunu , önde gelen ana bileşenlerden birine yaklaşırken, tüm sütunlar aynı anda yinelenir. Ana hesaplama, X T (XR) ürününün değerlendirilmesidir . Örneğin, LOBPCG'de uygulanan verimli engelleme, hataların birikmesini ortadan kaldırır, yüksek seviyeli BLAS matris-matris ürün işlevlerinin kullanılmasına izin verir ve tek vektör tek tek tekniğe kıyasla tipik olarak daha hızlı yakınsamaya yol açar.

NIPALS yöntemi

Doğrusal olmayan yinelemeli kısmi en küçük kareler (NIPALS) , bir temel bileşen veya kısmi en küçük kareler analizinde ilk birkaç bileşeni hesaplamak için uygulanan çıkarma yoluyla matris sönümlemeli klasik güç yinelemesinin bir çeşididir . *omik bilimlerinde (örneğin, genomik , metabolomik ) oluşturulanlar gibi çok yüksek boyutlu veri kümeleri için, genellikle yalnızca ilk birkaç PC'yi hesaplamak gerekir. Doğrusal olmayan yinelemeli kısmi en küçük kareler (NIPALS) algoritması gelen skorlar ve yükleri güncellemeleri yinelemeli yaklaşımlar t 1 ve r, 1 , T ile güç yineleme ile her yineleme çarparak X , hesaplanmasıdır solda ve sağda, kovaryans matrisinden, X T X'e güç yinelemelerinin matrissiz uygulanmasında olduğu gibi, X T (X r) = ((X r) T X) T ürününü değerlendiren fonksiyona dayalı olarak kaçınılır .

Çıkarma matris söndürme dış çarpılması ile gerçekleştirilir, t 1 r, 1 , T den X daha sonra gelen PC'leri hesaplamak için kullanılan sönük artan matriksin bırakır. Büyük veri matrisleri veya yüksek derecede sütun eşdoğrusallığına sahip matrisler için, NIPALS , her yinelemede biriken makine hassas yuvarlama hataları ve çıkarma yoluyla matris sönmesi nedeniyle PC'lerin ortogonallik kaybından muzdariptir . Bu ortogonallik kaybını ortadan kaldırmak için her yineleme adımında hem puanlara hem de yüklemelere bir Gram-Schmidt yeniden ortogonalizasyon algoritması uygulanır. Tek vektör çarpımı ile NIPALS bağımlılığı yüksek düzeyde faydalanarak alamaz BLAS kümelenmiş birincil tekil için ve yavaş yakınsama sonuç değerleri -hem bu yetersizlikler (örneğin yerel olarak en uygun blok önceden uygun eşlenik yön gibi daha karmaşık matris içermeyen blok çözen, giderilen LOBPCG ) yöntemi.

Çevrimiçi/sıralı tahmin

Verilerin tek bir partide saklanmak yerine parça parça ulaştığı bir "çevrimiçi" veya "akış" durumunda, PCA projeksiyonunun sırayla güncellenebilen bir tahminini yapmak yararlıdır. Bu verimli bir şekilde yapılabilir, ancak farklı algoritmalar gerektirir.

PCA ve nitel değişkenler

PCA'da, nitel değişkenleri tamamlayıcı unsurlar olarak tanıtmak istememiz yaygındır. Örneğin, bitkiler üzerinde birçok nicel değişken ölçülmüştür. Bu bitkiler için, örneğin bitkinin ait olduğu tür gibi bazı niteliksel değişkenler mevcuttur. Bu veriler nicel değişkenler için PCA'ya tabi tutuldu. Sonuçları analiz ederken, temel bileşenleri nitel değişken türlere bağlamak doğaldır . Bunun için aşağıdaki sonuçlar üretilmiştir.

- Farklı türlerin faktöriyel düzlemlerde tanımlanması, örneğin farklı renkler kullanılarak.

- Aynı türe ait bitkilerin ağırlık merkezlerinin faktöriyel düzlemlerde temsili.

- Her ağırlık merkezi ve her eksen için, ağırlık merkezi ile orijin arasındaki farkın önemini değerlendirmek için p değeri.

Bu sonuçlar, nitel bir değişkeni tamamlayıcı unsur olarak tanıtmak olarak adlandırılan şeydir . Bu prosedür Husson, Lê & Pagès 2009 ve Pagès 2013'te detaylandırılmıştır. Çok az yazılım bu seçeneği "otomatik" bir şekilde sunar. Bu, böyledir SPAD tarihsel olarak çalışmasının ardından Ludovic Lebart , bu seçeneği, ve R paket öneren ilk oldu FactoMineR .

Uygulamalar

kantitatif finans

Gelen kantitatif finans , temel bileşenler analizi doğrudan uygulanabilir risk yönetimi ve faiz oranı türev portföyleri. Genellikle 30-500 diğer piyasa kotasyonlu takas enstrümanlarının bir fonksiyonu olan çoklu takas enstrümanlarının alım satımı, makro bazda faiz oranlarının yolunu temsil eden genellikle 3 veya 4 ana bileşene indirgenmeye çalışılır. Bunlar olarak temsil edilecek riskleri faktör yüklerine (veya çarpanlara) dönüştürmek, bireysel 30-500 kovaya ilişkin riskleri basitçe toplu olarak görüntülemek için mevcut olanın ötesinde değerlendirmeler ve anlayış sağlar.

PCA , hem portföy riskine hem de risk getirisine benzer şekilde hisse senedi portföylerine de uygulanmıştır . Bir uygulama, temel hisse senetleri yerine "ana portföylere" tahsis stratejilerinin uygulandığı portföy riskini azaltmaktır . İkincisi, yukarı yönlü potansiyele sahip hisse senetlerini seçmek için ana bileşenleri kullanarak portföy getirisini artırmaktır .

sinirbilim

Nörobilimde , bir nöronun aksiyon potansiyeli oluşturma olasılığını artıran bir uyarıcının spesifik özelliklerini tanımlamak için temel bileşenler analizinin bir çeşidi kullanılır . Bu teknik, başak tetiklemeli kovaryans analizi olarak bilinir . Tipik bir uygulamada, deneyci bir uyaran olarak (genellikle ya bir denek için duyusal bir girdi olarak ya da doğrudan nörona enjekte edilen bir akım olarak) bir beyaz gürültü sürecini sunar ve bir uyaran olarak üretilen bir dizi aksiyon potansiyelini ya da sivri uçları kaydeder. Sonuç olarak nöron. Muhtemelen, uyaranın belirli özellikleri, nöronun ani yükselme olasılığını artırır. Bu özellikleri elde etmek amacıyla, deneyci hesaplar kovaryans matrisi arasında başak tetiklenen topluluğu , bütün uyarılarda grubu hemen bir artış önce (tipik olarak 100 ms mertebesinde, sonlu bir zaman penceresi üzerinde tanımlanır ve discretized). Özvektörler başak tetiklenen kovaryans matrisi ve kovaryans matrisi arasındaki farkın önceden uyaran topluluğu (aynı uzunlukta zaman penceresi üzerinden tanımlanan bütün uyarılarda grubu), daha sonra yön işaret alanı uyaranların olan varyansı boyunca dikenle tetiklenen topluluk, önceki uyaran topluluğundan en çok farklıydı. Spesifik olarak, en büyük pozitif özdeğerlere sahip özvektörler, başak ile tetiklenen topluluğun varyansının önceki varyansa kıyasla en büyük pozitif değişikliği gösterdiği yönlere karşılık gelir. Bunlar, uyaranın değiştirilmesinin bir ani artışa yol açtığı yönler olduğundan, genellikle aranan ilgili uyaran özelliklerinin iyi tahminleridir.

Sinirbilimde PCA, bir nöronun kimliğini aksiyon potansiyelinin şeklinden ayırt etmek için de kullanılır. Spike sıralama önemli bir prosedürdür çünkü hücre dışı kayıt teknikleri genellikle birden fazla nörondan sinyal alır. Ani sıralamada, aksiyon potansiyeli dalga formlarının uzayının boyutsallığını azaltmak için ilk önce PCA kullanılır ve ardından spesifik aksiyon potansiyellerini bireysel nöronlarla ilişkilendirmek için kümeleme analizi yapılır.

Bir boyut küçültme tekniği olarak PCA, özellikle büyük nöron topluluklarının koordineli aktivitelerini tespit etmek için uygundur. Beyindeki faz geçişleri sırasında kolektif değişkenlerin yani düzen parametrelerinin belirlenmesinde kullanılmıştır .

Diğer yöntemlerle ilişki

yazışma analizi

Uyumluluk analizi (CA), Jean-Paul Benzécri tarafından geliştirilmiştir ve kavramsal olarak PCA'ya benzer, ancak verileri (negatif olmaması gereken) satırlar ve sütunlar eşit olarak ele alınacak şekilde ölçeklendirir. Geleneksel olarak beklenmedik durum tablolarına uygulanır . CA , bu tabloyla ilişkili ki-kare istatistiğini ortogonal faktörlere ayrıştırır . CA tanımlayıcı bir teknik olduğu için ki-kare istatistiğinin uygun olup olmadığı tablolara uygulanabilir. Eğilimden arındırılmış uyum analizi ve kurallı uyum analizi dahil olmak üzere çeşitli CA varyantları mevcuttur . Özel bir uzantı, kategorik veriler için temel bileşen analizinin karşılığı olarak görülebilen çoklu uygunluk analizidir .

Faktor analizi

Temel bileşen analizi, orijinal değişkenlerin doğrusal kombinasyonları olan değişkenler yaratır. Yeni değişkenler, değişkenlerin hepsinin ortogonal olduğu özelliğine sahiptir. PCA dönüşümü, kümelemeden önce bir ön işleme adımı olarak yardımcı olabilir. PCA, bileşenlerin değişkenin hem ortak hem de benzersiz varyansını yansıttığı toplam değişken varyansını yeniden üretmeyi amaçlayan varyans odaklı bir yaklaşımdır. PCA genellikle veri azaltma (yani, değişken alanı optimal faktör uzayına çevirme) amaçları için tercih edilir, ancak amaç gizli yapı veya faktörleri tespit etmek olduğunda tercih edilmez.

Faktör analizi , temel bileşen analizine benzer, çünkü faktör analizi aynı zamanda değişkenlerin doğrusal kombinasyonlarını da içerir. PCA'dan farklı olarak faktör analizi, faktörlerin "benzersiz varyans hariç değişkenlerin ortak varyansını temsil ettiği" değişkenler arasındaki karşılıklı ilişkileri yeniden üretmeye çalışan korelasyon odaklı bir yaklaşımdır. Korelasyon matrisi açısından bu, köşegen dışı terimleri (yani, paylaşılan ortak varyansı) açıklamaya odaklanmaya karşılık gelirken, PCA köşegen üzerinde oturan terimleri açıklamaya odaklanır. Bununla birlikte, bir yan sonuç olarak, köşegen üstü terimleri yeniden üretmeye çalışırken, PCA ayrıca köşegen dışı korelasyonlara nispeten iyi uyma eğilimindedir. PCA ve faktör analizi tarafından verilen sonuçlar çoğu durumda çok benzerdir, ancak bu her zaman böyle değildir ve sonuçların önemli ölçüde farklı olduğu bazı sorunlar vardır. Faktör analizi genellikle araştırma amacı veri yapısını (yani, gizli yapıları veya faktörleri) veya nedensel modellemeyi tespit ettiğinde kullanılır . Faktör modeli yanlış formüle edilmişse veya varsayımlar karşılanmıyorsa, faktör analizi hatalı sonuçlar verecektir.

K -kümeleme anlamına gelir

Küme göstergeleri tarafından belirtilen k-araç kümelemesinin gevşetilmiş çözümünün temel bileşenler tarafından verildiği ve ana yönler tarafından yayılan PCA altuzayının küme ağırlık merkezi altuzayıyla özdeş olduğu iddia edilmiştir . Bununla birlikte, PCA'nın k-araç kümelemesinin yararlı bir gevşemesi olduğu yeni bir sonuç değildi ve küme ağırlık merkezi alt uzayının ana yönler tarafından kapsandığı ifadesine karşı örnekleri ortaya çıkarmak kolaydır.

Negatif olmayan matris çarpanlara ayırma

Negatif olmayan matris çarpanlara ayırma (NMF), matrislerdeki yalnızca negatif olmayan öğelerin kullanıldığı bir boyut küçültme yöntemidir ve bu nedenle astronomide astrofiziksel sinyallerin negatif olmaması anlamında umut verici bir yöntemdir. NMF bileşenlerinin tümü negatif değildir ve bu nedenle ortogonal olmayan bir temel oluştururken, PCA bileşenleri birbirine diktir.

PCA'da, her bileşenin katkısı, deneysel verilerin analizinde kesirli artık varyansa (FRV) eşdeğer olan karşılık gelen özdeğerinin büyüklüğüne göre sıralanır. NMF için bileşenleri yalnızca ampirik FRV eğrilerine göre sıralanır. Artık kesirli özdeğer grafikleri, yani toplam bileşen verilen bileşen sayısının bir fonksiyonu olarak , PCA için düz bir platoya sahiptir, burada yarı statik gürültüyü ortadan kaldırmak için hiçbir veri yakalanmaz, ardından eğrilerin bir göstergesi olarak hızlı bir şekilde düştüğü fazla sığdırır ve rastgele gürültüyü yakalar. NMF bileşenleri sıralı olarak oluşturulduğunda NMF için FRV eğrileri sürekli olarak azalmaktadır , bu da yarı statik gürültünün sürekli olarak yakalanmasını gösterir; daha sonra NMF'nin daha az aşırı uydurma özelliğini gösteren PCA'dan daha yüksek seviyelere yakınsar.

Korelasyonların ikonografisi

Veriler çeşitli kökenlerden birçok değişken içerdiğinde veya bazı değişkenler niteliksel olduğunda, temel bileşenleri yorumlamak genellikle zordur. Bu, PCA kullanıcısını çeşitli değişkenlerin hassas bir şekilde ortadan kaldırılmasına götürür. Gözlemlerin veya değişkenlerin eksenlerin yönü üzerinde aşırı bir etkisi varsa, bunlar kaldırılmalı ve daha sonra tamamlayıcı elemanlar olarak projelendirilmelidir. Ayrıca faktöriyel düzlemin merkezine yakın noktalar arasındaki yakınlıkları yorumlamaktan kaçınmak gerekir.

Korelasyonlarının resimleme eksenlerinin bir sistemde bir çıkıntı değildir, aksine, bu dezavantajlara sahip değildir. Bu nedenle tüm değişkenleri tutabiliriz.

Diyagramın ilkesi, düz çizgi (pozitif korelasyon) veya noktalı çizgi (negatif korelasyon) ile korelasyon matrisinin "dikkate değer" korelasyonlarının altını çizmektir.

Güçlü bir korelasyon, doğrudan değilse, üçüncü bir değişkenin etkisinden kaynaklanıyorsa "dikkate değer" değildir. Tersine, zayıf korelasyonlar "dikkate değer" olabilir. Örneğin, bir Y değişkeni birkaç bağımsız değişkene bağlıysa, Y'nin bunların her biri ile olan korelasyonları zayıf ve yine de "dikkate değer"dir.

genellemeler

seyrek PCA

PCA'nın özel bir dezavantajı, temel bileşenlerin genellikle tüm girdi değişkenlerinin doğrusal kombinasyonları olmasıdır. Seyrek PCA , sadece birkaç girdi değişkeni içeren doğrusal kombinasyonlar bularak bu dezavantajın üstesinden gelir. Girdi değişkenlerine seyreklik kısıtlaması ekleyerek verilerin boyutluluğunun azaltılması için klasik temel bileşen analizi (PCA) yöntemini genişletir. Dahil olmak üzere çeşitli yaklaşımlar önerilmiştir.

- bir regresyon çerçevesi,

- bir dışbükey gevşeme/yarı tanımlı programlama çerçevesi,

- genelleştirilmiş bir güç yöntemi çerçevesi

- alternatif bir maksimizasyon çerçevesi

- ileri-geri açgözlü arama ve dal-sınır tekniklerini kullanan kesin yöntemler,

- Bayes formülasyon çerçevesi.

Seyrek PCA'nın metodolojik ve teorik gelişmeleri ile bilimsel çalışmalardaki uygulamaları yakın zamanda bir anket makalesinde gözden geçirildi.

Doğrusal olmayan PCA

Doğrusal olmayan boyut indirgeme için modern yöntemlerin çoğu, teorik ve algoritmik köklerini PCA veya K-ortalamalarında bulur. Pearson'ın orijinal fikri, bir dizi veri noktasına "en uygun" olacak düz bir çizgi (veya düzlem) almaktı. Trevor Hastie , Şekilde gösterildiği gibi, veri yaklaşımı için açıkça bir manifold oluşturan, ardından noktaları üzerine yansıtan , PCA'nın geometrik yorumunun doğal uzantısı olarak Temel eğrileri önererek bu kavramı genişletti . Ayrıca bkz. elastik harita algoritması ve temel jeodezik analiz . Bir diğer popüler genellemedir çekirdek PCA PCA için karşılık pozitif kesin kernel ile ilişkili çekirdekli bir Hilbert uzayında gerçekleştirilir.

Gelen çoklu doğrusal alt uzay öğrenme , PCA için genelleştirilmiş olan PCA Çoklineer ekstreler tensör temsiller doğrudan öne çıkardığına (MPCA). MPCA, tensörün her modunda yinelemeli olarak PCA gerçekleştirilerek çözülür. MPCA, yüz tanıma, yürüyüş tanıma vb. için uygulanmıştır. MPCA, ilişkisiz MPCA, negatif olmayan MPCA ve sağlam MPCA'ya daha da genişletilmiştir.

N- yollu temel bileşen analizi, Tucker ayrıştırması , PARAFAC , çoklu faktör analizi, eş-atalet analizi, STATIS ve DISTATIS gibi modellerle gerçekleştirilebilir .

Sağlam PCA

PCA matematiksel olarak en uygun yöntemi bulsa da (kare hatasının en aza indirilmesinde olduğu gibi), yine de, yöntemin ilk etapta kaçınmaya çalıştığı büyük hatalar üreten verilerdeki aykırı değerlere karşı hassastır . Bu nedenle, PCA'yı hesaplamadan önce aykırı değerleri kaldırmak yaygın bir uygulamadır. Ancak, bazı bağlamlarda aykırı değerlerin belirlenmesi zor olabilir. Örneğin, korelasyon kümeleme gibi veri madenciliği algoritmalarında , noktaların kümelere ve aykırı değerlere atanması önceden bilinmemektedir. Ağırlıklı bir PCA'ya dayanan yakın zamanda önerilen bir PCA genellemesi, tahmini alaka düzeyine göre veri nesnelerine farklı ağırlıklar atayarak sağlamlığı artırır.

L1-norm formülasyonlarına ( L1-PCA ) dayalı olarak, PCA'nın aykırı değerlere dayanıklı varyantları da önerilmiştir .

Düşük sıralı ve seyrek matrislerde ayrıştırma yoluyla sağlam temel bileşen analizi (RPCA), PCA'nın büyük ölçüde bozulmuş gözlemlere göre iyi çalışan bir modifikasyonudur.

benzer teknikler

Bağımsız bileşen analizi

Bağımsız bileşen analizi (ICA), temel bileşen analizi ile benzer sorunlara yöneliktir, ancak ardışık yaklaşımlar yerine toplamsal olarak ayrılabilir bileşenleri bulur.

Ağ bileşeni analizi

Verilen bir matris , onu öyle iki matrise ayırmaya çalışır . PCA ve ICA gibi tekniklerden önemli bir fark, bazı girişlerin 0 ile sınırlandırılmış olmasıdır. Burada düzenleyici katman olarak adlandırılır. Genel olarak böyle bir ayrıştırmanın birden fazla çözümü olabilirken, aşağıdaki koşulların sağlanması durumunda şunu ispatlarlar:

- tam sütun sıralaması var

- Her sütununda en az sıfır olmalıdır, burada sütun sayısı (veya alternatif olarak satır sayısı ). Bu kriterin gerekçesi, bir düğüm, kendisine bağlı tüm çıkış düğümleriyle birlikte düzenleyici katmandan çıkarılırsa, sonucun yine de tam sütun sıralı bir bağlantı matrisi ile karakterize edilmesi gerektiğidir.

- tam satır sıralamasına sahip olmalıdır.

o zaman ayrıştırma bir skaler ile çarpmaya kadar benzersizdir.

Diskriminant analizi bileşen analizi

Temel bileşenlerin diskriminant analizi (DAPC), genetik olarak ilişkili bireylerin kümelerini tanımlamak ve tanımlamak için kullanılan çok değişkenli bir yöntemdir. Genetik varyasyon iki bileşene ayrılır: gruplar arasındaki ve gruplar içindeki varyasyon ve ilkini en üst düzeye çıkarır. Lineer diskriminantlar, kümeleri en iyi ayıran alellerin lineer kombinasyonlarıdır. Bu nedenle, bu ayrımcılığa en fazla katkıda bulunan aleller, gruplar arasında en belirgin şekilde farklı olanlardır. Alellerin DAPC tarafından tanımlanan gruplamalara katkıları, gruplar arasında genetik farklılaşmaya neden olan genom bölgelerinin belirlenmesine izin verebilir DAPC'de, veriler önce bir temel bileşen analizi (PCA) kullanılarak dönüştürülür ve ardından kümeler, diskriminant analizi (DA) kullanılarak tanımlanır.

Adegenet paketi kullanılarak R üzerinde bir DAPC gerçekleştirilebilir. (daha fazla bilgi: https://adegenet.r-forge.r-project.org/ )

Yazılım/kaynak kodu

- ALGLIB - PCA ve kesilmiş PCA uygulayan bir C++ ve C# kitaplığı

- Analytica – Yerleşik EigenDecomp işlevi, temel bileşenleri hesaplar.

- ELKI – PCA'nın sağlam varyantlarının yanı sıra PCA tabanlı kümeleme algoritmaları dahil olmak üzere projeksiyon için PCA'yı içerir .

-

Gretl – temel bileşen analizi,

pcakomut veyaprincomp()işlev aracılığıyla gerçekleştirilebilir . -

Julia –

pcaMultivariateStats paketindeki işlevle PCA'yı destekler - KNIME – Analiz için Java tabanlı bir düğüm düzenleme yazılımı, bunda PCA, PCA hesaplama, PCA Apply, PCA ters olarak adlandırılan düğümler bunu kolayca yapar.

- Mathematica – Hem kovaryans hem de korelasyon yöntemlerini kullanarak PrincipalComponents komutuyla temel bileşen analizini uygular.

- MathPHP – PCA destekli PHP matematik kütüphanesi.

-

MATLAB İstatistik Araç Kutusu – Fonksiyonlar

princompvepca(R2012b) temel bileşenleri verirken, fonksiyonpcaresdüşük dereceli bir PCA yaklaşımı için artıkları ve yeniden yapılandırılmış matrisi verir. - Matplotlib – Python kitaplığı, .mlab modülünde bir PCA paketine sahiptir.

- mlpack – C++'da temel bileşen analizinin uygulanmasını sağlar .

-

NAG Kitaplığı – Temel bileşenler analizi,

g03aarutin aracılığıyla uygulanır (Kitaplığın her iki Fortran sürümünde de bulunur). - NMath – .NET Framework için PCA içeren tescilli sayısal kitaplık .

-

GNU Octave – Çoğunlukla MATLAB ile uyumlu olan özgür yazılım hesaplama ortamı, işlevin

princomptemel bileşenini verir. - OpenCV

-

Oracle Database 12c –

DBMS_DATA_MINING.SVDS_SCORING_MODEAyar değeri belirtilerek uygulandıSVDS_SCORING_PCA - Turuncu (yazılım) – PCA'yı görsel programlama ortamına entegre eder. PCA, kullanıcının temel bileşenlerin sayısını etkileşimli olarak seçebileceği bir dağılma grafiği (açıklanan varyans derecesi) görüntüler.

- Origin – Pro versiyonunda PCA içerir.

- Qlucore – PCA kullanarak anında yanıt veren çok değişkenli verileri analiz etmek için ticari yazılım.

-

R – Ücretsiz istatistik paketi, fonksiyonlar

princompveprcomptemel bileşen analizi için kullanılabilir; genellikle daha iyi sayısal doğruluk sağlayan tekil değer ayrıştırmasınıprcompkullanır . , R PCA uygulamak içerir, ancak bunlarla sınırlı değildir Bazı paketler: , , , , ve .ade4veganExPositiondimRedFactoMineR - SAS – Tescilli yazılım; örneğin, bkz.

- Scikit-learn – Ayrıştırma modülünde PCA, Olasılıksal PCA, Çekirdek PCA, Seyrek PCA ve diğer teknikleri içeren makine öğrenimi için Python kitaplığı.

- Weka – Temel bileşenleri hesaplamak için modüller içeren makine öğrenimi için Java kitaplığı.

Ayrıca bakınız

- Yazışma analizi (olasılık tabloları için)

- Çoklu uygunluk analizi (nitel değişkenler için)

- Karma verilerin faktör analizi (nicel ve nitel değişkenler için)

- kanonik korelasyon

- CUR matris yaklaşımı (düşük sıralı SVD yaklaşımının yerini alabilir)

- Eğilimsiz yazışma analizi

- Dinamik mod ayrıştırması

- özyüz

- Açıklayıcı faktör analizi (Wikiversity)

- faktöriyel kodu

- Fonksiyonel temel bileşen analizi

- Geometrik veri analizi

- Bağımsız bileşen analizi

- Çekirdek PCA'sı

- L1-norm ana bileşen analizi

- Düşük dereceli yaklaşım

- matris ayrıştırma

- Negatif olmayan matris çarpanlara ayırma

- Doğrusal olmayan boyutsallık azaltma

- Oja'nın kuralı

- Nokta dağıtım modeli (morfometri ve bilgisayarla görüye uygulanan PCA)

- Temel bileşen analizi (Wikibooks)

- Temel bileşen regresyonu

- Tekil spektrum analizi

- Tekil değer ayrışımı

- seyrek PCA

- Kodlamayı dönüştür

- Ağırlıklı en küçük kareler

Referanslar

daha fazla okuma

- Jackson, JE (1991). Temel Bileşenler için Kullanıcı Kılavuzu (Wiley).

- Jolliffe, IT (1986). Temel Bileşen Analizi . İstatistikte Springer Serileri. Springer-Verlag. s. 487 . CiteSeerX 10.1.1.149.8828 . doi : 10.1007/b98835 . ISBN'si 978-0-387-95442-4.

- Jolliffe, IT (2002). Temel Bileşen Analizi . İstatistikte Springer Serileri. New York: Springer-Verlag. doi : 10.1007/b98835 . ISBN'si 978-0-387-95442-4.

- Husson François, Lê Sébastien ve Pages Jérôme (2009). R Kullanarak Örnekle Keşfedici Çok Değişkenli Analiz . Chapman & Hall/CRC The R Series, Londra. 224p. ISBN 978-2-7535-0938-2

- Pages Jerome (2014). R Kullanarak Örnekle Çoklu Faktör Analizi . Chapman & Hall/CRC The R Series London 272 p

Dış bağlantılar

- Rasmus Bro tarafından Kopenhag videonun Üniversitesi ile YouTube

- Andrew Ng Stanford Üniversitesi Video üzerindeki YouTube

- Temel Bileşen Analizi Üzerine Bir Eğitim

- Temel bileşenler analizine Bir anlayabileceği giriş üzerinde YouTube (az 100 saniyelik bir videoda.)

- StatQuest: Temel Bileşenler Analizi (PCA) açık bir şekilde izah üzerinde YouTube

- Ayrıca Yazılım uygulamalarının listesine bakın

![{\displaystyle {\begin{hizalanmış}\operatöradı {cov} (PX)&=\operatöradı {E} [PX~(PX)^{*}]\\&=\operatöradı {E} [PX~X^{ *}P^{*}]\\&=P\operatöradı {E} [XX^{*}]P^{*}\\&=P\operatöradı {cov} (X)P^{-1}\ \\end{hizalanmış}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0e4800248eafcc33b2c22c5613f06b0c2455faad)