Maksimum bir posteriori tahmin - Maximum a posteriori estimation

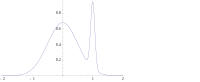

In Bayes istatistik , bir maksimum sonradan olasılık ( MAP ) tahmin eşittir bilinmeyen bir miktar, bir tahminidir modu arasında arka dağılımı . MAP, ampirik verilere dayalı olarak gözlemlenmemiş bir miktarın nokta tahminini elde etmek için kullanılabilir . Maksimum olabilirlik (ML) tahmini yöntemiyle yakından ilgilidir , ancak tahmin etmek istediği miktar üzerinden önceki bir dağıtımı (ilgili bir olayın önceden bilinmesi yoluyla elde edilebilen ek bilgileri nicelleştiren) birleştiren artırılmış bir optimizasyon hedefi kullanır . Bu nedenle MAP tahmini, maksimum olasılık tahmininin bir düzenlenmesi olarak görülebilir .

Açıklama

Gözlemlere dayalı olarak gözlemlenmemiş bir popülasyon parametresini tahmin etmek istediğimizi varsayalım . Izin olmak örnekleme dağılımı ait böylece olasılığıdır yatan nüfus parametresi olduğunda . Ardından işlev:

olabilirlik işlevi ve tahmin olarak bilinir :

maksimum olasılık tahminidir .

Şimdi, üzerinde önceki bir dağıtımın var olduğunu varsayalım . Bu bize tedavi sağlayan bir şekilde rastgele değişken olduğu gibi Bayes istatistik . Biz hesaplayabilir arka dağılımını ait kullanılarak Bayes teoremi :

burada yoğunluğu fonksiyonu , etki alanıdır .

Daha sonra maksimum bir posteriori tahmin yöntemi, bu rasgele değişkenin arka dağılımının modu olarak tahmin eder :

Arka dağılımın paydası (sözde marjinal olasılık ) her zaman pozitiftir ve buna bağlı değildir ve bu nedenle optimizasyonda hiçbir rol oynamaz. MAP tahmini gözlemleyin önce ML kestirimi ile çakışır düzgün (yani, bir bir sabit fonksiyon ).

Zaman kaybı fonksiyonu formda olan

olarak 0 gider Bayes tahmin dağılımı koşuluyla, MAP tahmincisi yaklaşımlar yarı-içbükeydir. Ancak genellikle bir MAP tahmincisi , ayrık olmadığı sürece bir Bayes tahmincisi değildir .

Hesaplama

MAP tahminleri birkaç yolla hesaplanabilir:

- Analitik olarak, arka dağılımın modları kapalı formda verilebildiği zaman . Bu, eşlenik öncüllerin kullanıldığı durumdur .

- Eşlenik gradyan yöntemi veya Newton yöntemi gibi sayısal optimizasyon yoluyla . Bu genellikle analitik veya sayısal olarak değerlendirilmesi gereken birinci veya ikinci türevleri gerektirir .

- Bir beklenti maksimizasyon algoritmasının modifikasyonu yoluyla . Bu, arka yoğunluğun türevlerini gerektirmez.

- Benzetilmiş tavlama kullanan bir Monte Carlo yöntemi ile

Sınırlamalar

MAP tahmininin Bayes tahmininin sınırlayıcı bir durumu olması için sadece hafif koşullar gerekli olsa da (0-1 kayıp fonksiyonu altında), genel olarak Bayes yöntemlerini pek temsil etmemektedir. Bunun nedeni, MAP tahminlerinin nokta tahminleri olmasına karşın, Bayes yöntemlerinin verileri özetlemek ve çıkarımlar yapmak için dağılımların kullanılmasıyla karakterize edilmesidir: bu nedenle, Bayes yöntemleri , güvenilir aralıklarla birlikte arka ortalama veya medyanı rapor etme eğilimindedir . Bunun nedeni, bu tahmin edicilerin sırasıyla hata karesi ve doğrusal hata kaybı altında optimal olmasıdır - bunlar tipik kayıp fonksiyonlarını daha iyi temsil eder - ve sürekli bir arka dağılım için MAP'ın optimal nokta tahmin edicisi olduğunu düşündüren hiçbir kayıp fonksiyonu yoktur. Ek olarak, arka dağıtım genellikle basit bir analitik biçime sahip olmayabilir: bu durumda, dağıtım, Markov zinciri Monte Carlo teknikleri kullanılarak simüle edilebilirken , modlarını bulmak için optimizasyon zor veya imkansız olabilir.

Karışım modelleri gibi birçok model türünde , arka çok modlu olabilir . Böyle bir durumda, olağan öneri, kişinin en yüksek modu seçmesidir: bu her zaman mümkün değildir ( küresel optimizasyon zor bir sorundur), hatta bazı durumlarda mümkün değildir (örneğin, tanımlanabilirlik sorunları ortaya çıktığında). Ayrıca, en yüksek mod, posteriorun çoğunluğunun karakteristik özelliği olmayabilir.

Son olarak, ML tahmin edicilerinden farklı olarak, MAP tahmini, yeniden parametreleme altında değişmez değildir . Bir parametreleştirmeden diğerine geçmek, maksimumun konumunu etkileyen bir Jacobian'ı tanıtmayı içerir.

Yukarıda bahsedilen Bayes tahmin edicileri (ortalama ve medyan tahmin ediciler) arasındaki farka bir örnek olarak ve bir MAP tahmini kullanarak, girdileri pozitif veya negatif olarak sınıflandırmanın gerektiği durumu düşünün (örneğin, krediler riskli veya güvenli olarak). Sadece üç olası sınıflandırma doğru yöntemi ile ilgili hipotez vardır varsayalım , ve posteriors sırasıyla 0.4, 0.3 ve 0.3 ile birlikte. Yeni bir örnek verildiğini varsayalım , bunu pozitif olarak sınıflandırırken, diğer ikisi bunu negatif olarak sınıflandırır. Doğru sınıflandırıcı için MAP tahminini kullanmak pozitif olarak sınıflandırılırken , Bayes tahmin edicileri tüm hipotezlerin ortalamasını alır ve negatif olarak sınıflandırır .

Misal

Bir sekansı verildiğini varsayalım bir IID rastgele değişken ve önceki bir dağılımı ile verilir . MAP tahminini bulmak istiyoruz . Normal dağılımın önceden kendi eşleniği olduğuna dikkat edin , bu nedenle analitik olarak kapalı formda bir çözüm bulabileceğiz .

Maksimize edilecek fonksiyon daha sonra şu şekilde verilir:

bu, aşağıdaki işlevi en aza indirmeye eşdeğerdir :

Böylece, μ için MAP tahmin edicisinin şu şekilde verildiğini görüyoruz :

bu, önceki ortalama ve ilgili kovaryansları ile ağırlıklandırılan numune ortalaması arasında doğrusal bir interpolasyon olduğu ortaya çıkar.

Durum, bilgilendirici olmayan bir öncel olarak adlandırılır ve kötü tanımlanmış bir önsel olasılık dağılımına yol açar; bu durumda

Referanslar

- DeGroot, M. (1970). Optimal İstatistiksel Kararlar . McGraw-Hill. ISBN 0-07-016242-5 .

- Sorenson Harold W. (1980). Parametre Tahmini: İlkeler ve Sorunlar . Marcel Dekker. ISBN 0-8247-6987-2 .

- Hald Anders (2007). "Normal Dağılımın Gauss Türetimi ve En Küçük Kareler Yöntemi, 1809". Bernoulli'den Fisher'a Parametrik İstatistiksel Çıkarımın Tarihi, 1713–1935 . New York: Springer. s. 55–61. ISBN 978-0-387-46409-1 .